Rangliste

Beliebte Inhalte

Inhalte mit der höchsten Reputation seit 19.03.2025 in allen Bereichen anzeigen

-

3 Punkte

-

Hi, also erstmal wünsche ich dir viel Kraft, dass das alles ohne weitere Probleme klappt und du zufrieden gestellt wirst. Aber ich muss schon sagen, den Laden so dermaßen schlecht zu reden und zu boykottieren finde ich schon etwas daneben. JA, es ist sehr ärgerlich, dass kein Techniker rausgeschickt wurde. Aber es wurde ja trotzdem direkt von Anfang an angeboten, dass Gerät einzuschicken. Natürlich sollte man Premium-Support erhalten, wenn man dafür viel Geld bezahlt. Ich kann bislang nur einen Reparaturauftrag bei Alienware/Dell verzeichnen, und das klappte reibungslos. Vielleicht ist es eine Verkettung von vielen blöden Zusammenhängen und es ist auch richtig diese Erfahrungen im Netz mit einer Community zu teilen... ob man jetzt die ganze Firma/Marke verteufeln muss, vor allem wenn man ja jahrelang IMMER sehr zufrieden war... weiß ich nicht. Wie gesagt. Ich hoffe es klappt am Ende so, wie es sein sollte. LG3 Punkte

-

Ich kann mich @pitha1337 im Grunde nur anschließen. @BerlinRockz Wenn ich das richtig verstanden habe, hattest Du ja vor etwa 3 Wochen den Vor-Ort-Service für den Austausch der Tastatur in Anspruch genommen. Dann, vor etwa 5 Tagen dann erneut Kontaktaufnahme mit Dell Support wegen der geschilderten Problemsituation. Während seitens Dell nur vorgeschlagen wird, das Gerät nunmehr einzuschicken ( sicher Abholung durch UPS), möchtest Du auf der Vor-Ort-Reparatur beharren. Ich hätte mir an Deiner Stelle auch gewünscht, dass wieder vor Ort repariert werden kann. Andererseits ist es für mich ehrlich gesagt nachvollziehbar, dass Dell das Gerät nun in der Werkstatt überprüfen will, wenn bei einem 5 Monate alten Gerät nach einem „Brand“, wie bei Dir offensichtlich, mehr als nur ein Teil beschädigt worden ist. Von der Rußverteilung bis in die Lüfter hinein mal abgesehen, ist ja nicht auszuschließen, dass nicht noch mehr Schaden entstanden ist. Gleichzeitig hat man eher dort die Möglichkeit auch den tatsächlichen Grund für den Schaden im Systemverbund zu analysieren. Das ist nochmal was anderes als Einzelteile zu testen. Schließlich soll die Lösung ja langfristig währen. Und ein Vor-Ort-Techniker tauscht in der Regel wirklich nur die Teile aus. Meiner Meinung nach spricht in Deinem Fall Vieles für eine ziemlich misslungene Kommunikation zwischen Dir und dem Dell Support. Andernfalls kann ich mir wirklich nicht erklären wie es zu einer derartigen Eskalation innerhalb von nur wenigen Tagen kommen kann. Dein „Fall“ ist ja noch ganz frisch und ich kann Dir aufgrund meiner Erfahrungen mit dem Dell Support nur raten, grundsätzlich immer freundlich zu kooperieren. In Deinem Fall würde ich deshalb Dell’s Ermessensspielraum, wie ein Schaden am besten beurteilt und behoben werden kann, respektieren, dh: Daten sichern, am besten anrufen, schnellstmöglich einen Abholtermin vereinbaren, damit nicht unnötig viel Zeit verschwendet wird. Je nach Ergebnis bekämest entweder Dein Gerät im funktionsfähigen Zustand zurück oder gar ein Ersatzgerät oder ein Refund. Der Zeitablauf würde so oder so von der Verfügbarkeit der benötigten Austauschkomponenten abhängen. Sofern von „refurbished“ Teilen die Rede ist, sind diese meines Wissens nicht abgenutzt, sondern auf Ihre Funktionsfähigkeit hin separat überprüft; z.T. aus nagelneuen Geräten der Baureihe, die aus verschiedensten Gründen (zB innerhalb von 14 Tagen) zurück gegangen sind. Generell können ab Fabrik eingebaute Komponenten auch fehlerhaft sein und dies sich erst im Nachhinein herausstellen. Sollten im Anschluß an eine Reparatur, sofern Du Dell überhaupt die Gelegenheit dazu gibst, etwa immer noch Hardware-Probleme auftauchen, ist es m.E. sehr unwahrscheinlich, dass man einem Wunsch nach Austausch oder Refund, nicht entsprechen würde. Wie gesagt, meine Empfehlung beruht auf Basis meiner jahrelangen positiven Erfahrungen mit dem Dell Support, die immer (!) ein Entgegenkommen gezeigt hat. Ich hoffe daher für Dich, dass sich eine weitergehende Eskalation vermeiden lässt und Du so letztlich zu einer vergleichsweise schnelleren Lösung gelangen kannst.3 Punkte

-

Ich habe alles richtig gemacht, es auseinandergenommen, die Kontakte gereinigt (sie waren wie neu, kein einziger Defekt oder Staubkorn, sie glänzten, als kämen sie gerade vom Band). das Problem bleibt bestehen Hallo Jörg! Ich befürchte, dass tatsächlich ein Defekt am Mainboard oder an der Grafikkarte vorliegt. Das Problem in der Ukraine ist, dass es unglaublich schwierig ist, Ersatzteile für ALIENWARE zu finden. Auch der Versand über eBay funktioniert nicht; In meinem Land herrscht Krieg. Nachdem ich die Foren und Reddit gelesen hatte, bemerkte ich, dass einige Leute dieses Problem von Anfang an hatten. Vielleicht ist mir das Gleiche passiert und ich habe es einfach nicht bemerkt (ich wiederhole, der Laptop funktioniert einwandfrei). Das ist mir bei CYBERPUNK 2077: Phantom Liberty v. 2.21 aufgefallen. Mit aktiviertem DLSS – FPS 6–21. Es war sehr auffällig. So kam es beispielsweise bei anderen Spielen zu Einbrüchen auf bis zu 40 FPS, die optisch jedoch nicht auffielen. der FPS-Unterschied zwischen PCIe x8 und PCIe x1 beträgt etwa 30 % Ich kann nur auf ein gutes Servicecenter hoffen, das den problematischen Teil des Motherboards oder der Grafikkarte findet und ersetzt. Denn im Allgemeinen sind sie Arbeiter. Ich vermute einfach, dass ein defekter Transistor das gesamte System zerstören wird. Aufrichtig Vlad Zum Vergleich FURMARK PCIe x8 FURMARK PCIe x1 (meins) Die gleichen 30% niedrigeren Ich halte Sie auf dem Laufenden (obwohl ich in absehbarer Zeit keinen guten Dienst finden werde) und hoffe, dass jemand im Forum eine „Wunderpille“ findet, mit der ich das Problem ohne einen Dienst lösen kann 😃 Tut mir leid, wenn Google Translate etwas falsch gemacht hat 😃 Frohe Ostern, Jörg, dude08/15 und alle anderen, die diese Nachricht lesen (und alle, die das nicht tun😉🤗)2 Punkte

-

Nummer 1 im Bild müsste die Datenleitung zum Mainboard sein und die Nummer 2 der Poweranschluss. Reinige die Kontakte der Karte und des Kabels (an beiden Enden) von Nummer 1 mit Isoprapanol, eventuell hat auch das Verbindungskabel selbst einen Defekt und muss getauscht werden. Falls nur ein Kontaktproblem vorliegt, glaube ich das eher nicht. @Jörg: Naja, fast:2 Punkte

-

Hi @janome1121, da die Nvidia Grafikkarte im Area 51m ja separat verbaut und somit nur in einem Slot eingesteckt ist hat diese vielleicht keinen korrekten elektrischen kontakt zum Mainboard. Deshalb würde ich versuchen die Karte mal auszubauen und die Kontaktflächen zu reinigen, evtl. löst dies ja dein Problem und es werden wieder 8 PCIe Lanes benutzt.2 Punkte

-

Ja, sehr. Ich hatte meinen Fall eröffnet, danach kamen in schneller Folge schriftliche Anfragen und Vorschläge bis zu einem Punkt, an dem der Service ein Hardware-Problem eingeräumt hatte. Die haben mich dann (aus Dublin) angerufen, zwei Tage später stand der Techniker vor meiner Tür. Erst Mainboard getauscht (erfolglos), dann Daughterboard. Und das wars. Es tauchte nie die Frage nach einem Eigenverschulden auf, obwohl ich schon zu Beginn geschildert hatte, dass das Problem mit einem selbst vorgenommenen Einbau einer zweiten SSD zeitlich in Verbindung steht. Das war ein wirklich positives Erlebnis.2 Punkte

-

OT zum Thread aber passend zur Diskussion: Geforce RTX 5090: Stromstecker schmelzen wieder2 Punkte

-

@Svencore, @Nuestra: Hut ab, großen Respekt vor soviel Herzblut und Arbeit, die ihr in eure Geräte gesteckt habt !! @kroenen04: Stimmt, und das ist auch gut so. Veränderungen müssen einfach sein und sind notwendig. Wenn alles gleich bliebe sähen unsere Fahrzeuge heute noch so aus wie ein Ford T-Modell . @Svencore: Schöner Scirocco, ist der 2 oder? Motormäßig Serie oder getunt? Aktuell noch Warteschleife, hat mehrere Gründe . Zum einen reizen mich mehrere Geräte, auch Apple ist mit dabei. Meinen XMG-Favouriten gibt es noch nicht mit neuer HW, da ist XMG wohl noch am testen. Ist aber ok so, besser langsam und dafür vernünftig. Außerdem sind mir da im Moment noch zu viele Kinderkrankheiten, vor allem was neue Grakas betrifft. Auch da gibt es für mich eine Favouritin, die Asus ROG Astral 5090. Bei dieser Karte gibt es aber ein Lautstärke-Problem aufgrund des vierten Lüfters. Asus hat zwar mit einem Bios nachgebessert, aber da möchte ich lieber noch warten. Alles noch viel zu früh, auch das Steckerproblem ist ja noch nicht geklärt. So wie ich das aktuell einschätze wird das vor Ende diesen Jahres nichts werden mit einem Kauf, vielleicht sogar erst Anfang nächstes Jahr. Ist aber auch ein wenig stimmungsabhängig. Kann auch gut möglich sein dass es ein Apple wird und ich mir zum spielen eine Konsole anschaffe. Im Moment steht noch alles offen . Gruß Jörg2 Punkte

-

2 Punkte

-

Der R4 sieht schon extrem aggressiv aus.Aber geil. Allerdings muss man sagen,dass der Trend z.Zt. eher mehr ins Schlichte und Minimalistische geht.Das sieht man ja auch an den neuen Geraeten. Aber es ist wie in der Mode...Alles kommt irgendwann wieder!😁2 Punkte

-

Ich find's zeitlos 😉, im Gegensatz zu den Aquarien 😅Hab das Teil mit mühevoller Arbeit restauriert und mit damals halbwegs aktueller HW aufgebaut, alles funktioniert. Wie ein alter Käfer, läuft und läuft...passend dazu mein Scirocco 😅👍👽 @Jörg: Wie ist denn der Stand mit Neuanschaffung bezüglich Desktop? oder weiter Warteschleife?🫣😅 Ich hänge den 90ern/2000ern noch immer gerne nach 😉Tolle und aufregende Zeit war's...auch HW technisch.2 Punkte

-

dell hat AW 2006 übernommen. der test vom Aurora R4 erschien 2012 bei HWL. schicke "kiste", so ganz anders wie der rest an PCs. so mag ich alienware, weit weg vom mainstreamdesign. https://www.hardwareluxx.de/index.php/artikel/hardware/komplettsysteme/21288-test-alienware-aurora-r4.html2 Punkte

-

@2f4me das findest du im Service Handbuch in deinem Bereich bei dell im Support Bereich. Schau Mal hier Klick2 Punkte

-

@Sk0b0ld: Im Grunde bildet sich der "Mehrwert" dieses Systems nur für Liebhaber dieser Marke und nicht über dessen HW bzw. Komponenten . Das stimmt, schon klar. Ja, deine Meinung kenne ich, und du liegst ja auch nicht falsch damit. Auch wenn ich persönlich den Area 51 nicht übel finde, werde/würde ich ihn aktuell zu 90% nicht kaufen. Also bitte nicht denken ich bin der absolute Fanboy, denn das bin ich ganz sicher nicht . Dennoch finde ich das Gerät als solches schon interessant und optisch ansprechend bzw. wertig, auch wenn es nicht das Beste vom Besten darstellt was die HW-Kompos angeht. AW sieht dieses System als reine Daddel-Kiste, und eben das finde ich sehr schade wie ich ja bereits schrieb. Ich möchte aber keinen reinen Gaming-PC, sondern ein ernstzunehmendes System mit tollen Konfi-Möglichkeiten, Qualitäts-HW, so wie auch du sie bevorzugst, mit dem man auch sehr gut spielen kann, wenn man es denn möchte. Darum ist für mich der XMG Studio X, der laut XMG weiterhin angeboten wird, zumindest im Moment mein Favourit. Gruß Jörg2 Punkte

-

Wenn dir die Karte noch was wert ist, lass es professionell instand setzen. https://krisfix.de/ Hat auch etliche Videos bei YT online. Alternativ sonst zur Deko umbauen, bevor unnötig Geld in alte Hardware verbrennt.2 Punkte

-

@David1984: Ist denn wirklich sichergestellt, dass die Graka defekt ist ?? Ein Flackern des Bildschirmes kann auch während der Installation des Graka-Treibers auftreten. Zusätzlich hat ePSA keinen Fehler festgestellt. Daher würde ich evtl. mit dem Austausch der Graka warten und ggf. erstmal versuchen, für günstiges Geld einen Akku zu besorgen und diesen dann einzubauen. Laut meinem Kenntnisstand gibt es Situationen, wo trotz Netzspannung dennoch zusätzlich etwas Strom aus dem Akku benötigt wird. Da dieser aber bei dir nicht vorhanden ist, könnte hier der Hund begraben sein. Letztendlich musst du selber entscheiden was du tust, ich würde erstmal mich auf den fehlenden Akku konzentrieren bevor ich auf Verdacht anfange, meine Graka rauszureißen und gegen eine andere zu tauschen. Das würde ich erst dann machen, wenn zu 100% feststeht, dass diese auch wirklich defekt ist. Gruß Jörg2 Punkte

-

Erstmal fertig für heute 🥴😴 Benchmarks bestanden, allerdings braucht die Graka wohl neue WLP und Pad's. 90 Grad Peak und sonst 87 Grad sind mir zuviel. Ist ne Gigabyte RTX 2080 Super. Ach und n bischen OC muss auch noch drin sein am System 👋😏 Jetzt aber erstmal Feierabend. Huch das eine Foto etwas verwischt 🙈2 Punkte

-

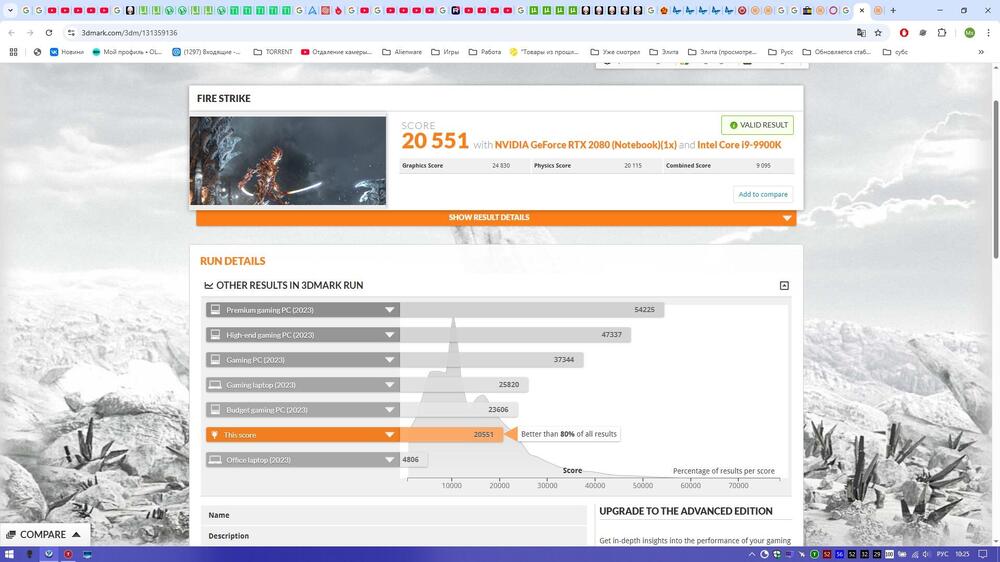

Ich habe noch etwas rumprobiert mit dem Omen Max 16, aber scheint wohl noch ein Software/BIOS Bug zu sein. Manchmal läuft das Notebook sauber, aber sobald man ein Spiel beendet oder Advanced Optimus den GPU Switch triggered gibt es regelmäßig einen kompletten "Black Screen". Ich denke es wird sich mit der Zeit lösen, jedoch für den Preis inakzeptabel. Zum Gerät selbst kann ich fast nur postives schreiben. Inbesondere die Oberflächentemparaturen und Lüfter Lautstärke sind erstklassig. Es ist das erste mal, dass ich bei einem 16" Gaming Notebook kalte Hände beim zocken hatte. Das OLED Display ist ebenfalls hervorragend, sowie Tastatur und allgemeine Verarbeitungsqualität. Die Leistung habt ihr ja in den Screenshots gesehen, auch hier gibt es nicht zu bemängeln. Ich habe noch keine Vergleichswerte aber der Ultra 9 scheint sehr heiß zu laufen, ich habe teilweise "Peaks" auf 105°C gesehen. Meistens pendelt sich die CPU bei 80-90°C ein. Gönnt sich dann aber auch 75W CPU + 160W GPU. Für meinen Geschmack etwas zu heiß, jedoch waren die Lüfter angenehm leise. Aufgefallen ist noch, dass die Lautsprecher selbst bei 100% nicht laut genug sind. Sie sind eher so wie 50% bei einem anderen Notebook, sicherlich auch noch ein Treiberproblem. Vom Klang her waren sie gut. Etwas merkwürdig fand ich den Netzteilanschluss, dieser ist sehr dünn und relativ lang. Hier hätte ich Sorge, dass dieser verbiegt oder sogar abbricht. Ingesamt würde ich sagen ein sehr gutes Notebook, wenn die Bugs ausgeräumt sind. Der Preis von 4500€ ist aber nicht gerechtfertigt, hier wären 800-1000€ weniger angebracht. Es ist halt immer noch ein HP, auch wenn ein sehr gutes1 Punkt

-

1 Punkt

-

Möglich ja, aber man sollte doch erst mal das einfachste versuchen um den Fehler einzugrenzen bevor die Karte teuer getauscht werden muss.1 Punkt

-

Erstmal an alle schöne Osterfeiertage! Es gibt wieder eine kleine Neuigkeit und zwar sind ab heute für die neuen Alienware Laptops (Alienware 16 Area-51 und Alienware 18 Area-51) im Dell Support Bereich, die Downloads und Treiber verfügbar. Die Dokumentation mit den technischen Details, gibt es ja schon etwas länger. Ich bin mal gespannt, wann jetzt der Release bei uns sein wird. Auf jeden Fall gibt es die neuen Alienware Laptops bisher nur in den USA und in Kanada.1 Punkt

-

1 Punkt

-

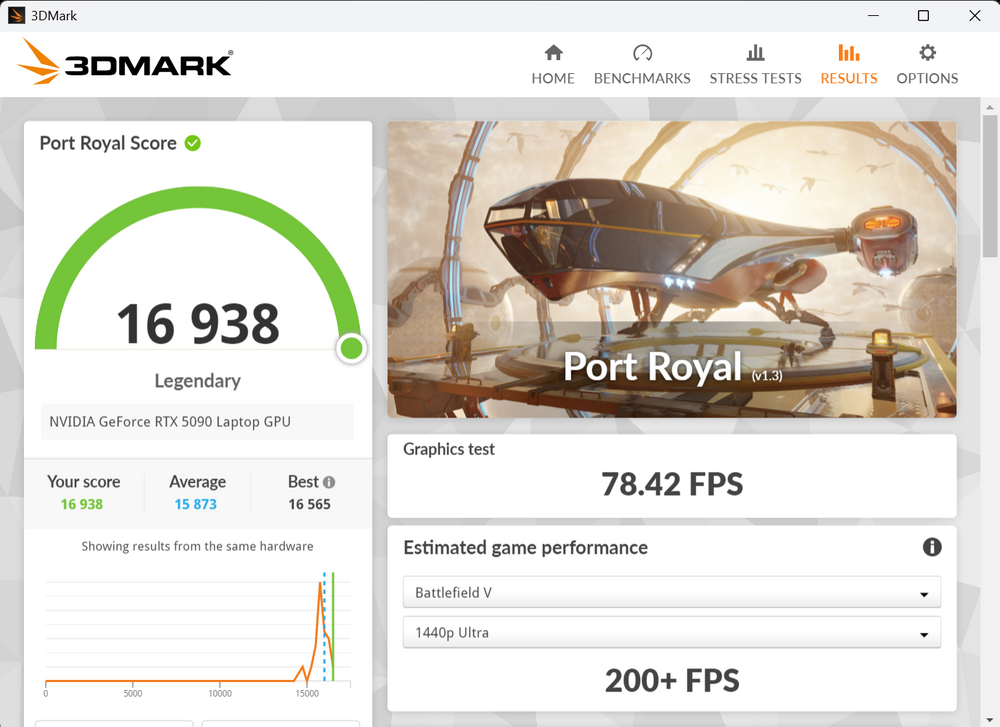

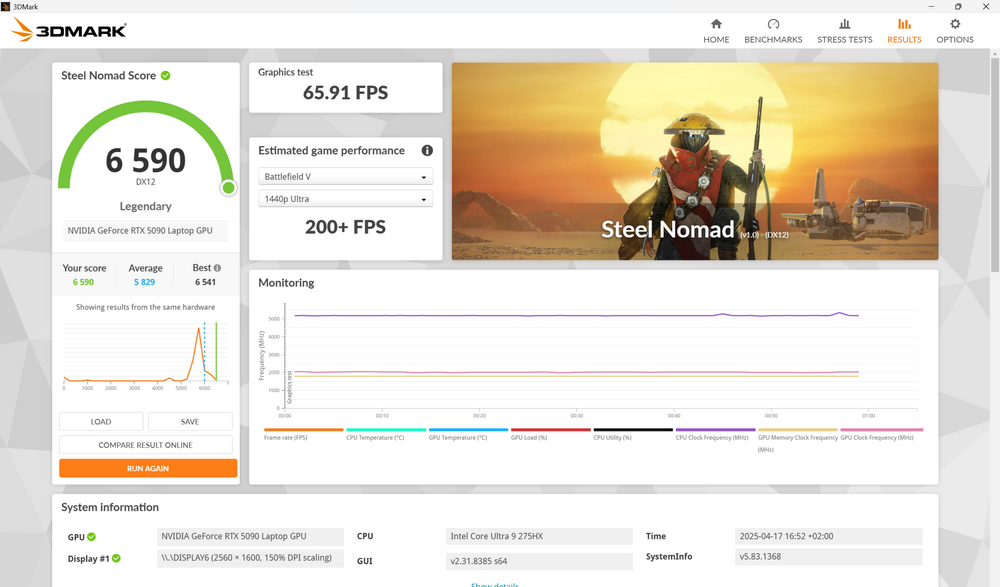

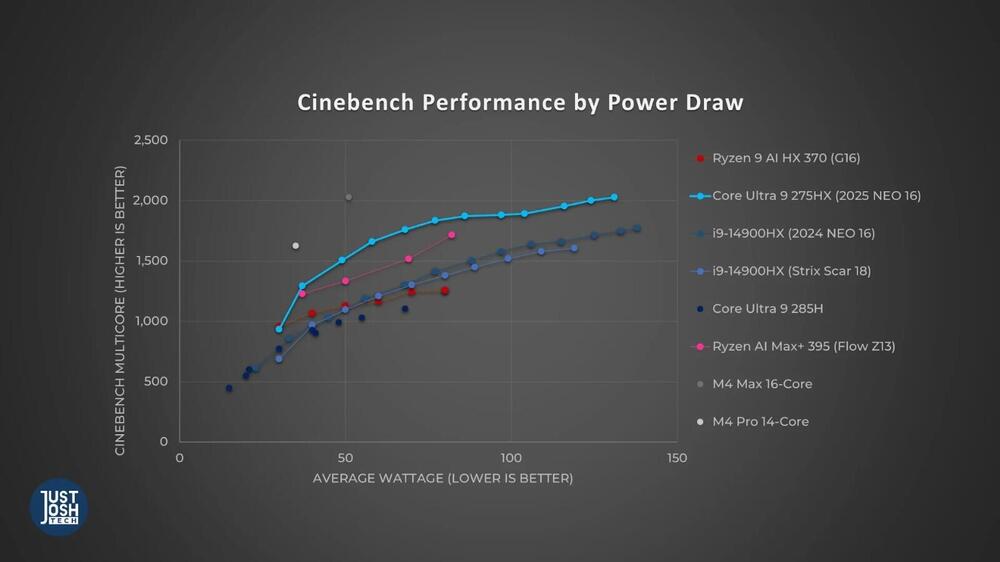

Viel Spaß damit. Bei mir ist gerade eben ein Asus ROG Strix Scar 18 mit 275HX und 5080 (5090 noch nicht lieferbar) eingetroffen. Packe es gleich aus. Das Razer Blade 18 (wird ab Ende des Monats ausgeliefert) schaue ich mir evtl. auch noch an. Edit: Ausgepackt: Schneller Ersteindruck: tolles schlichtes Design (noch besser als es auf den Fotos aussieht) gut verarbeitet, Metalldeckel und steife Scharniere (besser als ich es erwartet habe) gute Tastatur, viel Hub das miniLED hat 2.000 Zonen, was MacBook Pro Niveau ist Nachfolgender Screenshot von der offiziellen Webseite. Mit dem Tool "G-Helper" (https://github.com/seerge/g-helper) müsste man alle Lüfter inkl. Lüfter-Kurven des Scar 18 (ohne Eingreifen der Firmware!) komplett steuern können (mit dem Zephyrus G16 geht es jedenfalls - selbst getestet). Ansonsten ist natürlich nice, dass nun auch die Intel-CPUs viel Leistung bei 70-80 W abliefern (mehr als ein 14900HX bei 150 W) und es somit kein geringes CPU-Limit mehr bei Crossload wie die Jahre zuvor bei Laptops gibt. Zumindest bei den CPUs gibt es nicht viel Unterscheid zu den Desktop-PCs. Ein GPU-Limit kann man mit Ingame-Settings ja gut beeinflussen, ein CPU-Limit aber nicht wirklich.1 Punkt

-

1 Punkt

-

1 Punkt

-

Um den Thread zum Abschluss zu bringen: Nach vielen Mails zwischen Dell und mir, vielen Versuchen, kam der Vor-Ort-Service und hat das Daughter-Board getauscht. Und nun tut der Sensor wieder, was er soll :-).1 Punkt

-

Das bauen macht Spaß und ist ganz easy. Schaff sogar ich mit 2 linken Händen;)1 Punkt

-

1 Punkt

-

Alles Top, habe ein neuwertiges Legion 9i erhalten. Das warten hat sich gelohnt, auch wenn es teilweise sehr frustrierend war1 Punkt

-

Hahahaha, ja, liegst du vollkommen richtig Ich wusste es😂Der nervte mich bei den Vintage Notebooks auch immer, wurde aber nach suche auch irgendwann fündig, nur ohne AW Branding dann. Tja, so ganz ohne frickelei geht's dann doch nicht, aber das wäre ja auch langweilig 🫣😅1 Punkt

-

@Svencore: Mein lieber Sven, das ist mir klar, ich weiß das . Natürlich kann ein Treiber und/oder eine Software, der/die ursprünglich für Windows 7,8,8.1 offiziell freigegeben ist, auch auf W10 oder gar W11 funktionieren. So "unglaublich" ist das also nicht, habe ich auch selber schon so gemacht. Nur darauf verlassen kann man sich halt nicht, man muss es also, wie du ja selber auch sagst, probieren. Komisch finde ich halt nur, dass dieses CC unter Windows 10 bei Dell halt nicht gelistet wird, obwohl W10 ja unterstützt und dementsprechend auch Treiber dafür angeboten werden, die hier und da ganz sicher vollkommen identisch mit den 8/8.1-Treibern sind. Das glaube ich dir aufs Wort. Ich hatte sowas in der Vergangenheit mal mit W10 auf meinem M18X R2 gemacht. Grundsätzlich hat das funktioniert, aber eben nicht zu 100%. Manche original Dell-Treiber ließen sich nicht installieren, konnte ich machen was ich wollte. Dafür musste ich dann recht zeitintensiv passende Ersatz-Treiber im Netz besorgen, was dann auch ging. Es wäre notfalls auch ohne diese Treiber gegangen, aber ich mag nunmal keine gelben Dreiecke, Fragezeichen/Ausrufezeichen etc. im Geräte-Manager 😉. Gruß Jörg1 Punkt

-

Der Top Nvidia Mobile Chip entspricht - leistungsmäßig - immer etwa einer xx70 Desktop. War in den letzen Generationen so, ist wieder so. Stimmt nicht so ganz. Bei eGPU kann die Desktop Karte auch nie ihre volle Leistung ausfahren, weil durch die Anbindung die Latenzen erheblich vergrößert werden. Wird bei TB5 nicht anders sein.1 Punkt

-

Wobei man fairerweise die 5090 Mobile eher mit einer 5080 Desktop wegen dem Chip vergleichen müsste. Für 150W eigentlich ordentlich. Würde mir aber wieder eine externe GPU Lösung wünschen, das hätte was. Für unterwegs zocken genug Leistung und wenn man daheim einen Desktop Ersatz möchte - extern dran und go. Den generellen Fortschritt von RTX4000 auf RTX5000 haben wir ja genügend durchdiskutiert.1 Punkt

-

Hothardware hat eine RTX 5090 Preview mit dem Razor 16 (2025) und dem MSI Raider A18HX mit AMD Ryzen 9955HX3D. GeForce RTX 5090 Laptop GPU Review: NVIDIA’s Best Mobile Gaming Chip Yet | HotHardware Es gibt ein paar Spiele Benchmarks und das MSI ist meistens der klare Sieger, der Abstand zu den 4090 Lösungen der letzten beiden Jahre ist aber nicht berauschend. Die mobile 5090 kommt erwartungsgemäß knapp unterhalb der Desktop 5070 heraus (mit dem MSI). Außerdem gibt es noch einen eigenen AMD Ryzen 9955HX3D Preview. AMD Ryzen 9 9955HX3D Fire Range HX3D Exclusive: Gaming Laptop Supercharger | HotHardware1 Punkt

-

Wie es in den Wald hinein schallt,so schallt es auch hinaus.Auf mich wirkst du sehr arrogant und streitlustig.Sorry.Da solltest du mal an dir arbeiten.Wenn ich schon hoere 2800 Euro kratzen dich nicht...ja warum machst du dann so einen Aufstand?Schicks doch einfach ein und kauf dir in der Zeit doch einfach 2 neue Geraete.:) Dell kratzt das nicht die Bohne was du da veranstaltest.Die geben das am Ende an ihre Rechtsabteilung weiter und du kannst warten bis du schwarz wirst.Dell und Alienware bekommen so viel Shitstorm von Neidern und Selbstbaufanatikern jeden Tag und ueberall...da willst du deren Image schaden?Ich denke du ueberschaetzt dich sehr. Aber in einem Punkt hast du Recht...man muss auf seinem Recht bestehen.Aber du hast scheinbar kein Recht auf einen Homeservice nach eigenem Ermessen.Also schick das Ding ein und mach nicht so ein Chaos.Jeden Tag schicken Leute ihre Geraete ein ohne zu maulen.Und wenn du keine Refurbishteile haben willst und Dell keine Neuen auf Lager hat,wirst du auch vom Techniker vor Ort keine kriegen. Dann musst du so lange warten,bis Dell wieder neue Teile auf Lager hat und wenn nicht wuerde ich mein Geld zurueckverlangen oder den Tausch gegen ein aktuelles gleichwertiges Geraet verlangen.In diesem Fall haettest du sogar noch plus gemacht.Und das machen die.Das kann ich aus eigener Erfahrung bestaetigen.1 Punkt

-

Verstehe dein Verständnis von Rechtsanspruch nicht. Dell will doch seinen Pflichten nach kommen und das Gerät reparieren, jedoch nicht bei dir vor Ort. Es macht aus Dell-Sicht aber keinen Sinn einen weiteren Techniker Vor-Ort zu schicken, da nicht absehbar ist was genau kaputt ist. Wirtschaftlich kann ich die Entscheidung also nachvollziehen. Für den Endverbrauche natürlich unbequem, aber nachvollziehbar. Wäre aber super interessant wie dein Fall am Ende ausgegangen ist Verstehe mich bitte nicht falsch, ich habe auch ein sehr hohes "Gerechtigkeitsgefühlt". Hatte da auch mal was mit DHL, bin da mit meiner Rechtsschutz dran geblieben und bin zu meine Recht gekommen. War aber auch ein Weg von 1,5 Jahren1 Punkt

-

Hmm dann wollen sie wirklich nicht. Ich würde es nun einschicken und sie werden ja selbst feststellen, dass da kein Wasser ist. Das würde auch komplett anders aussehen und andere Effekte haben. Dann bekommst du einen Ersatz und der Fall ist erledigt. Nervig natürlich darauf zu warten, aber sie zeigen sich ja zumindest etwas "einsichtig". Alternativ selbst einen Gutachter bezahlen und denen das um die Ohren hauen, falls sie immer noch meinen es sei ein Wasserschaden.1 Punkt

-

Früher über RTSS, seit geraumer Zeit nutze ich nur noch den Treiber / die Nvidia App. Der limiter dort in aktueller Version (glaube V3) steht mittlerweile RTSS in nichts mehr nach bzw. hat sogar noch Vorteile. Nicht zuletzt hat das auch den Vorteil, dass ich RTSS nicht zusätzlich benötige (und Afterburner eh nicht). Als Tool läuft bei mir nur noch FanControl zum Steuern aller Lüfter im System und HWiNFO (letzteres aus Neugierde / zum Anschauen diverser Werte wie Temperaturen).1 Punkt

-

Hab das Video zwar nur überflogen, finde es aber schwierig: keine Zahlen / fps wie soll ohne FG ein Plus von 65% zu Stande kommen? Das schreit nach unfairem Vergleich (Settings) und/oder auch nach anderem CPU-/Ram-Limit für mich geht es zu viel um FG (auch wenn logisch ist, dass Nvidia das massiv bewirbt und somit auch so einige YouTuber...). In AC Shadows ist FG wirklich annehmbar, für mich aber auch das erste Spiel, wo man es gebrauchen kann (bin aber zugegebenermaßen empfindlich und spiele AC Shadows lieber mit 100 fps cap ohne FG als mit mehr fps und mit FG. Das hat zwei Gründe: Erstens ist der Inputlag ohne FG natürlich immer besser und zweitens sind die 1% percentil min-fps bei so Spielen eh stets unter 100 fps, somit gibt es keine so hohe Diskrepanz zwischen average- und min-fps, woran FG nämlich nichts ändert)1 Punkt

-

Mehrere Sachen sind mir auf der Dell Seite noch aufgefallen. Alienware m16 R2 aktuell nicht mehr bestellbar, egal in welcher Konfiguration. Desweiteren gibt es bis zum 03. April 2025 doppelte Dell Rewards-Punkte, was auch ein Indiz dafür sein könnte, das genau ab dann die neuen Geräte verfügbar sein werden. Aber alles nur Theorie und nichts handfestes. Aber das in dem Youtube Video mit dem 03.04.2025, sehe ich dennoch als realistisch an, das passt einfach alles sehr gut zusammen.1 Punkt

-

Upscaling kann man aber nicht als Maßstab hernehmen. Dafür ist es noch zu problembehaftet. Nativ ist immer besser als DLSS/FSR. Und wenn der Upscaler aktiv ist, dann bist du meist sowieso an der Grenze/in dem Bereich wo die Monitor Hz liegen, drüber möchte man nicht gehen. Was ich noch zählen lasse wären die 1% lows. Aber da kann man bei keinem meckern.1 Punkt

-

1 Punkt

-

Und wer kein AM5 Board hat braucht alles neu. Dann schaut man anders drauf 7950x3d, schau dir PCGH Daves Beiträge in den Foren an und die Tests, da hats Sheduling nicht mal nach 1 Jahr richtig funktioniert. Wenn ich 2 Zusatzprogramme laufen lassen muss...sorry das geht besser und haben sie jetzt beim 9950x3d gezeigt und selbst da ist es nicht optimal. Und warum packen die CPUs im Optimum nur 6000MHz? Richtig, der I/O-Die ist nicht zeitgemäß bei Zen5 und 1:1 von Zen4 übernommen. Die CPUs könnten noch weitaus besser performen. Zen5 ist einfach eine Gewinnmaximierung Gen. Bisschen optimiert, alte node, alter I/O und fertig. Heißt bei den Memes nicht umsonst Zen5%. Und bei Intel zum Release Ultra 9 -2,85k. Nvidia fang ich nicht an, die haben den Vogel komplett abgeschossen. Also die Big 3 haben sich alle nicht mit Ruhm bekleckert. Da wo die 13/14 Intel gen abgeraucht ist, fackelt jetzt die X3D CPU ab (vermute aber hier Mainboard Hersteller als schuldigen). Die kochen alle nur mit Wasser. Ist nicht alles Gold was glänzt. Nur das pauschale Intel Bashing ist nicht gerechtfertigt. V.a. wenn man die CPU nicht mal selbst getestet hat und nur auf rewiev Balken schaut die nichtmal den optimalen RAM nutzen oder wo die Bios Version nicht bekannt ist. Ohne Konkurrenz durch Intel gehts uns dann - wie oben bereits angemerkt - wie mit Nvidia.1 Punkt

-

Erzaehl das mal Apple.Da kriegste 10x so schwache Technik wie in einem AW zum selben Preis.Ich finde es immer bescheuert wenn sich Selbstbauer und Fans einer Marke bekriegen.Der Selbstbauer will halt nur die beste Technik fuer sein Geld und die Marke ist ihm egal.Der Fan ist bereit fuer die Marke auch auf etwas Leistung zu verzichten.Wo ist das Problem? Am Ende wenn ich meinen Aurora anschmeisse und ein Game spiele wird der Unterschied zu einem Selbstgebauten System genau 3 Frames betragen.Im besten Fall.Bei Benchmarks sieht es da ev.anders aus,aber das ist auch ein anderes Hobby.Doch selbst da spielt mein PC ganz vorne mit.Also warum soll ich mir selber einen PC bauen,wenn ich doch gerne einen Alienware haben moechte? Der Selbstbauer versucht immer dem Alienwarefan seine Geldverschwendung aufzuzeigen...aber er vergisst immer den Wert,den die Marke fuer den Fan hat.Vom Service ganz zu schweigen,den man bei Dell bekommt.Der ist fuer viele sicher auch wichtig.Aber davon will ich garnicht anfangen.Es geht mir rein nur um das nackte System. Achso und noch was zum Aufruesten: Mein guter alter 2600k hat jahrelang ausgereicht um wirklich jedes Spiel was die GPU schaffte mitzutragen.Die CPU ist fuer Gamer bei weitem nicht so wichtig wie die CPU.Klar darf kein Bottleneck entstehen..aber mal ehrlich bei Spielen ist das nicht so relevant wie bei Benchmarks.1 Punkt

-

Es ist - für mich persönlich - nice to have. Mehr aber auch nicht. In meinem Fall habe ich das "Topmodell" drin, daher interessieren mich die Upgrades auf lange Zeit nicht. Ich kann alles damit machen, sowohl im Gaming als auch im produktiven Bereich. Verkauft wird bei mir auch nie etwas, das wandert dann in der Familie weiter bis zum Defekt. Finde die Z890 Plattform als Ganzes besser als AM5. Dadurch das AM5 zu allem kompatibel bleiben muss, ist die Multi gen Langlebigkeit nicht immer ein Vorteil. Persönliche Präferenz eben. Ich sehe das oft in meinem Bekanntenkreis, dass die dann seit AM5 immer ein Upgrade gemacht haben und nur gamen...das ist waste of money. Für paar Frames, die sich dann auf 144Hz Monitore sowieso nicht auswirken.1 Punkt

-

NVIDIA Treiber ist da https://videocardz.com/driver/nvidia-geforce-game-ready-572-83?fbclid=IwZXh0bgNhZW0CMTEAAR1xQanMpGQVhE3AQBdccVQakdu-j-sMnWGxPDrvqQDO2y2EPpZ9Dn_BT1c_aem_TUNWS9jSCtYoviJwoC-kOQ1 Punkt

-

Man muss zu dem Area 51 R2 Projekt auch sagen das es ein Sammlerstück ist, deswegen auch so original wie möglich. Mein Stiefsohn darf den für Fortnite,CS Go zocken benutzen, mehr muss der nicht können, geht mir ums haben ist besser als brauchen 😉 Da könntest du ja auch noch ne 2,5 SSD reinpacken, brauchst aber einen Adapter von 3,5 auf 2,5 Zoll dann.1 Punkt

-

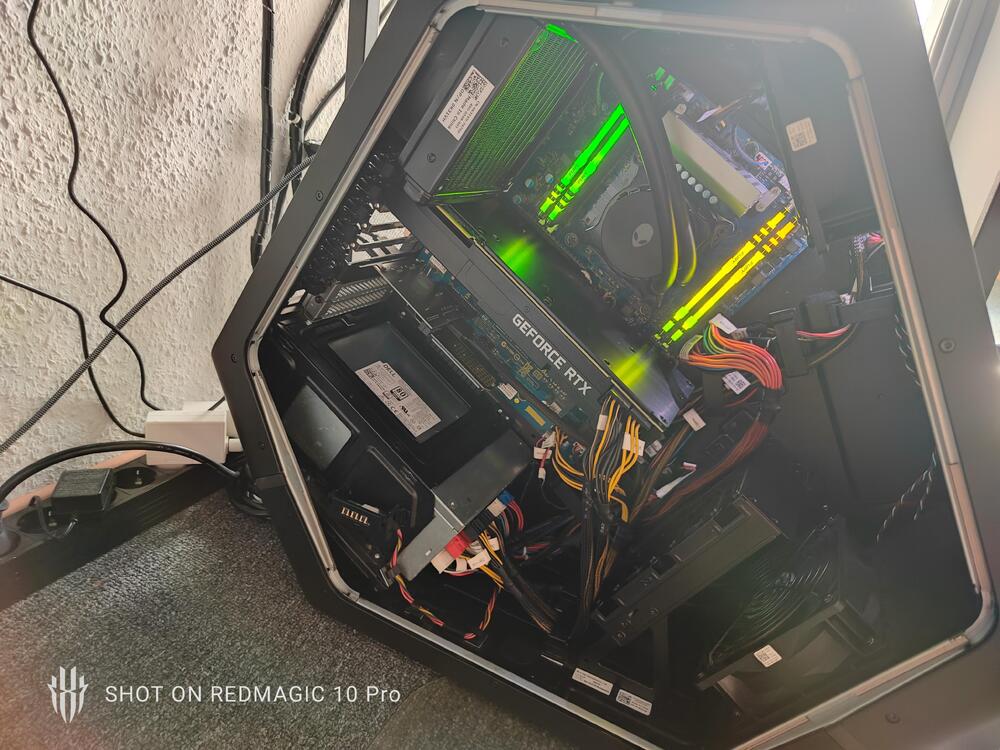

Mein Projekt restaurierung/Upgrade eines Area 51 R2 läuft bestens, er ist nach 4 Jahren im Keller erwacht heute das erste mal. Vorher "alles" komplett zerlegt, gereinigt, neuen RAM, neue Graka, neue SSD'S,WLP usw. läuft bis jetzt wie geschmiert die Kiste 👍 🙃😊😜Jetzt dabei am Win11 einrichten,Treiber usw.1 Punkt

Diese Rangliste nutzt Berlin/GMT+02:00 als Grundlage

.thumb.jpg.4024e90166344449a9704f4ff655f0eb.jpg)

.thumb.jpg.6a0f1c2eecba90d71541704934e25071.jpg)