-

Gesamte Inhalte

1.908 -

Benutzer seit

-

Letzter Besuch

-

Tagessiege

264

Inhaltstyp

Profile

Forum

Kalender

Downloads

Treiberreihenfolgen

Alienware Geräte-Lexikon

Alle Inhalte von Sk0b0ld

-

Über die Namensgebung von Nvidia, Intel und Co. brauchen wir uns nicht unterhalten. Gerade Nvidia hat 2019 ordentlich für Chaos gesorgt. Neben den regulären RTX Karten, kamen dann Super-Karten + die 16XXer Reihe (1650, 1660 Ti, 1660 Ti Max-Q und und und). Da blickt auch keine Sau mehr durch. Bleiben wir aber im High-End Segment der Notebooks, sagen wir mal RTX 2070 und RTX 2080, kann man das ganze grob in 2 Klassen aufteilen, zumindest aus Performance-Sicht. RTX 20XX Max-Q (85w - 110w) RTX 20XX non-MQ (140w - 200w) Die MQ Versionen werden meinst in den Thin & Light Notebooks eingesetzt (Razer Blade, Alienware m15/ m17 etc.). Zwar ist der Chip (DIE) der selbe wie bei den Desktop-Pedants, jedoch laufen die GPUs aufgrund der strom- und thermaltechnischen Voraussetzung (VRM + Netzteil) mit geringerem Takt und anderen Limits. Die non-MQ Karten, die teilweise eine Leistungsaufnahme bis 200w haben, unterscheiden sich zumindest leistungstechnisch, nicht mal all zu sehr von den Desktop-Karten. Jedenfalls wenn man Nvidias RTX 2080 FE als Referenz nimmt (215w - 225w). Partnerkarten wie meine MSI RTX 2080S beispielsweise haben standardmäßig eine max. Leistungsaufnahme von 250w. Logisch das man mit mehr Strom auch mehr Leistung rausziehen kann. Da der Chip bei allen Karten der gleiche ist, (was wahrscheinlich mit ein Grund ist für den Wegfall des Kürzels ist) definiert sich die Leistung mehr über VRM, Kühlung und Limits. Ein weiterer Grund für die Namensgebung könnten Marketinggründe sein. So als ob Nvidia sagen möchte, dass die Notebook-GPUs, den Desktop-Pedants im nichts nachstehen. Das Ergebnis war mit dem 200w Limit oder? Wobei man fairerweise sagen muss, dass deine Scores mit zu den höchsten überhaupt gehören und nicht unbedingt als Referenz für den Standard-User genommen werden können, falls FoxMulder jetzt anfängt zu vergleichen. Ist halt so ähnlich wie die Kühlwerte von meinem R5, die für die meisten User unrealistisch sind. Zeigt aber sehr wohl, was tatsächlich möglich ist, wenn man nur will. Aber ja, so im groben kann ich das wohl bestätigen mit den +10%. Mit meiner 2080S und leichtem OC (+110/ +750) hole ich bei FS 32.237 Grafikpunkte, was irgendwo 10-12% entspricht, wobei ich die Kotzgrenze meiner Karte noch nicht ausprobiert habe. Zocken mit den Einstellungen geht problemlos, wobei der Stromverbrauch zu dem Plus an FPS in keinem gesunden Verhältnis mehr steht.

-

Alle Modelle (Notebooks) (PL)Undervolt

Sk0b0ld antwortete auf Sk0b0ld's Thema in Allgemeines & Troubleshooting

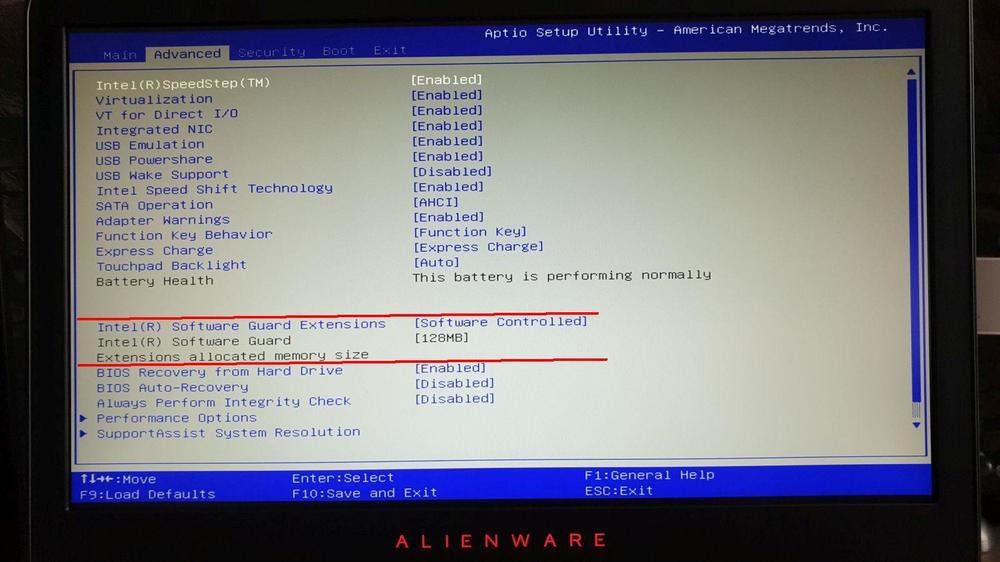

Das Risiko ist nicht an oder ausschalten, sondern die Updates an sich. Gut möglich, dass du dann überhaupt nicht mehr entscheiden kannst, ob du es an- oder ausmachen kannst. Denkbar wäre auch, dass du es zwar an oder ausstellen kannst, dass Sicherheitsfeature trotzdem aktiv bleibt und den Zugriff auf die CPU unterbindet. Ich weiß nicht wie Alienware das in Zukunft handhaben wird. Hoffentlich lassen sie uns die Freiheit, die Geräte weiterhin zu optimieren. Einfach bisschen googlen oder in die Links schauen. Zitat laut Intel: "Die Intel® Software Guard Extensions (Intel® SGX) ermöglichen eine hardwarebasierte Verschlüsselung von Speicherinhalten, die bestimmten Programmcode und Daten im Speicher isoliert. Mit Intel® SGX kann Programmcode von Anwendungen eigene, als Enklaven bezeichnete Speicherbereiche belegen, die vor Prozessen, die auf höherer Privilegierungsstufe ausgeführt werden, geschützt sind. Nur Intel® SGX bietet einen solchen Grad an Kontrolle und Schutz. " Ich will hier gar nicht so auf Intels Verschlüsselungstechniken oder hardwarenahen Programmcode eingehen, sondern mehr auf zukünftige Updates und die Problematik mit Alienware Geräten. Notebook Review Forum. Ich habe die Links hinzugefügt. @captn.ko, als er gefragt hatte, hatte ich nur den einen Link von NBRF (-Beispiel-) drin, nicht aber das Wort NBRF explizit. Hab's jetzt nachträglich noch mal erfasst. -

Dieses Thema ist schon relativ lange bekannt und wird auch schon länger in diversen Forenkreisen diskutiert. In unser Forum hat es Plundervolt, zumindest bis jetzt, noch nicht geschafft, da die daraus resultierenden Nachteile aktuell keine Alienware-Geräte betreffen, jedenfalls noch. Da sich das aber in Zukunft ändern könnte und das zum Teil für uns erhebliche Nachteile hat, wollte ich das Thema zumindest schon mal ansprechen. Was genau ist Plundervolt? Plundervolt bezeichnet eine Sicherheitslücke bei Intel Prozessoren, wodurch es möglich ist Schadcode auszuführen. Die Sicherheitslücke betrifft Intel's Software Guard Extensions, abgekürzt auch SGX genannt. Dieser Punkt befindet sich bei uns im BIOS unter dem Reiter Advanced. Welche Nachteile hat es für mich? Intel und diverse andere Hersteller haben schon reagiert und bieten BIOS-Updates an, die wie üblich, irgendwelche Sicherheitslücken schließen. Das Problem ist dabei, dass man durch so ein Update, die Möglichkeit verliert, irgendwelche Änderungen an der CPU über ThrottleStop oder Intel XTU vorzunehmen. Natürlich auch über's BIOS selbst. Was bedeutet, dass man unter anderem nicht mehr Undervolten oder andere Voltage-/ Core-Settings durchführen kann. Ich kann jetzt nicht sagen, welche Hersteller genau damit schon angefangen haben. Soweit ich weiß, trifft das zumindest schon mal auf HP zu. User mit den Omen Notebooks kotzen sich in Foren (z.B. NBRF) darüber aus, dass die CPU ohne undervolting deutlich heißer läuft (logisch) und es keine Möglichkeit mehr gibt, das Setting mit dem SGX Update anzupassen. Außer man downgraded die BIOS-Versoin, sofern das möglich ist. Mittlerweile finden sich auch immer mehr Beiträge im Alienware-Bereich des NBRF, wo dieser Punkt jedesmal nach einem BIOS Update gefragt wird. -Beispiel- Wenn ich jetzt an meinen R5 und dem i9-8950HK denke, dann wäre so eine Beschränkung ziemlich besch***en für mein System und ich denke, ich spreche da nicht nur für mich alleine. Das BIOS Updates immer mit einer gewissen Vorsicht zu genießen sind, ist an sich nichts neues. Wenn jetzt aber solche Einschränkungen mit den BIOS Updates kommen, würde ich mir ein Update zwei mal überlegen. Deshalb wollte ich schon mal sicherheitshalber drauf hinweisen. Wer sich in das Thema weiter einlesen möchte und detaillierte Informationen sucht, kann sich folgende Links anschauen: Weiterführende Links und Quellen: - Plundervolt.com - ZDnet.com (Plundervolt) - Bob (Youtube) - Intel Software Guard eXtensions (Intel)

-

Alienware m17 R1 Laptop wird extrem heiss

Sk0b0ld antwortete auf Winstonblue's Thema in Allgemeines & Troubleshooting

Danke für's Feedback, Jörg. Naja, ich hatte ja schon mehrmals über die Wärmeleitpad- & Heatstink-Problematik bei dem m15 R1 berichtet -Link-. Da sieht der m17 leider nicht viel aus. Da kann man sich noch so viele Heatsinks nachbestellen, bringt nur nichts, wenn alle Pads immer vorinstalliert und somit festgeklebt sind. Reicht ja schon wenn 1-2 Pads die falsche Dicke haben und die Heatsink nicht tief genug auf den DIE kommt. Das ist auch nicht unbedingt ein Fehler, den man den "Technikern" vorwerfen kann, denn schließlich kann man nicht davon ausgehen, dass die über Jahre in einem markenbezogenem Forum sitzen und jede Schwachstelle, Unregelmäßigkeit einer Heatsink eines bestimmten Models kennen. Ich selber weiß das ja nur, weil ich das verhältnismäßig oft bei den AW-Geräten mache und in dem Zusammenhang auch viel teste. Deswegen gebe ich meine Erkenntnisse, Tipps usw. im Forum weiter, weil ich glaube, dass schon dem ein oder anderem helfen könnte. Wenn ich ganz viel Glück habe, schaut sich das ja vielleicht auch mal ein Techniker an ? Wenn die Kühlung aber passt, ist das Notebook wirklich klasse. Bin mit meinen m15 immer noch super zufrieden. Auch der m15 mit'm i9-8950HK und der RTX 2080 MQ war sehr gut. @Winstonblue, Was die Kühlgeschichte beim Area51m angeht, konnte ich bislang sehr positive Eindrücke sammeln. Für "Out-of-the-Box"-Verhältnisse sahen Paste und Pads bislang immer sehr gut aus. -

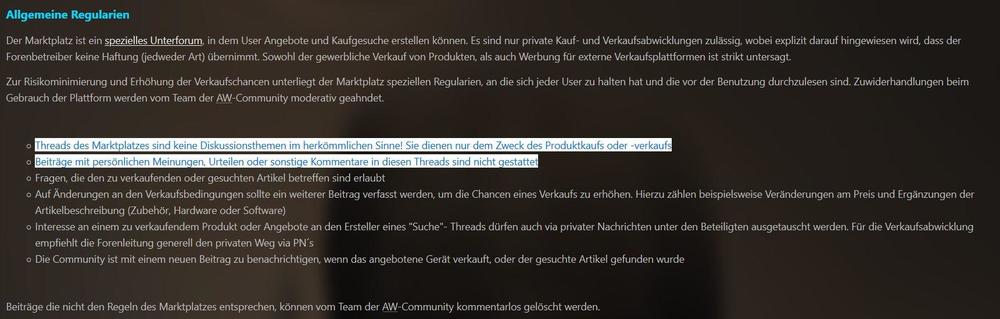

Das Lesen nicht zu deinen größten Stärken gehört, hast du mir in der Vergangenheit schon einige male paar gezeigt. Daher weiße ich dich nochmals auf unsere Marktplatzregeln hin: Des Weiteren antwortest du auf eine nicht gestellte Frage. Er hat in keiner Zeile erwähnt, dass er mit der gesuchten Ausstattung ausschließlich spielen möchte oder ob irgendwas besser oder schlechter performt. Ist ja schön und gut, dass du dich im Forum so viel beteiligst, nur sollte das schon mit Sinn und Verstand passieren. Jeder weitere Kommentar, wird direkt gelöscht, der nicht den Marktplatzregeln entspricht. (siehe Anhang, unterster Abschnitt)

-

Alienware 17 R5 Alienware 17 R5 RAM Upgrade

Sk0b0ld antwortete auf GermanPlayer85's Thema in Upgrades - Do-it-Yourself

Die passen ohne Probleme. Hatte sie im R4, habe sie ebenfalls im R5 und im m15 R1. Wie K54 schon richtig sagte, sind sie mit CL15 so ziemlich die schnellsten DIMMs, die man in der 2.666er Taktung bekommt. -

All Powerful M17X R3 Bitte um Rat bei CPU/GPU Upgrade

Sk0b0ld antwortete auf Artamstart's Thema in Upgrades - Do-it-Yourself

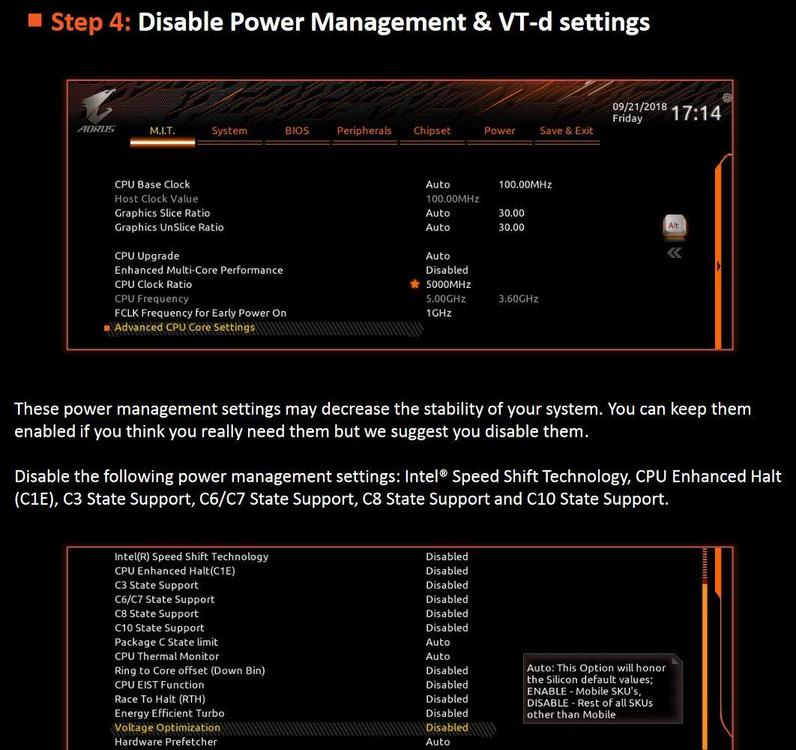

Auch wenn ich mir relativ sicher bin, dass es eigentlich nicht daran liegen sollte, besteht ja vielleicht doch ein kleiner Hoffnungsschimmer. Und zwar, hast schon mal die C-States und Speedstep deaktiviert? Gigabyte schreibt in ihrem Z390 OC-Guide folgendes: Normalerweise sind das alles Settings, die bei OC zur Systemstabilität beitragen sollen. Wer weiß aber wie damals programmiert wurde und wann welche Option freigegeben wird. Ich habe leider das Gerät nicht und auch kaum Erfahrung mit so alten Geräten. Daher bleibt dir nur der Weg über probieren, probieren und probieren. Naja, aber wenn du Glück hast, hilft es ja vielleicht. Hast ja jetzt eh Zeit^^. -

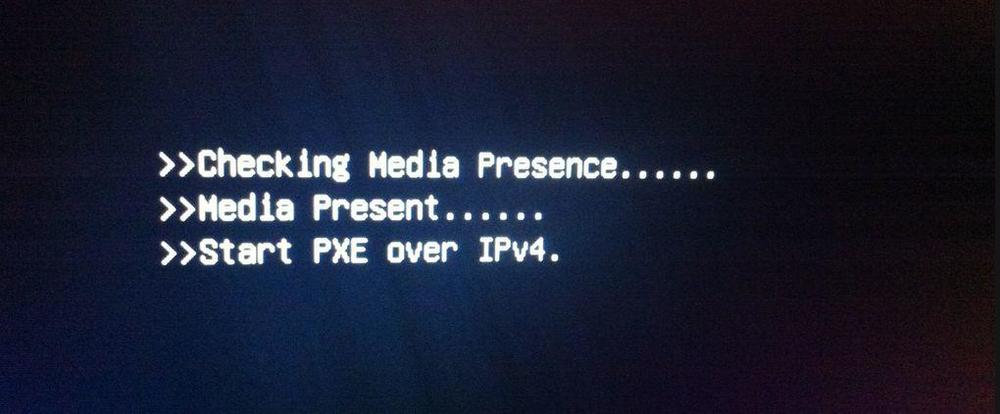

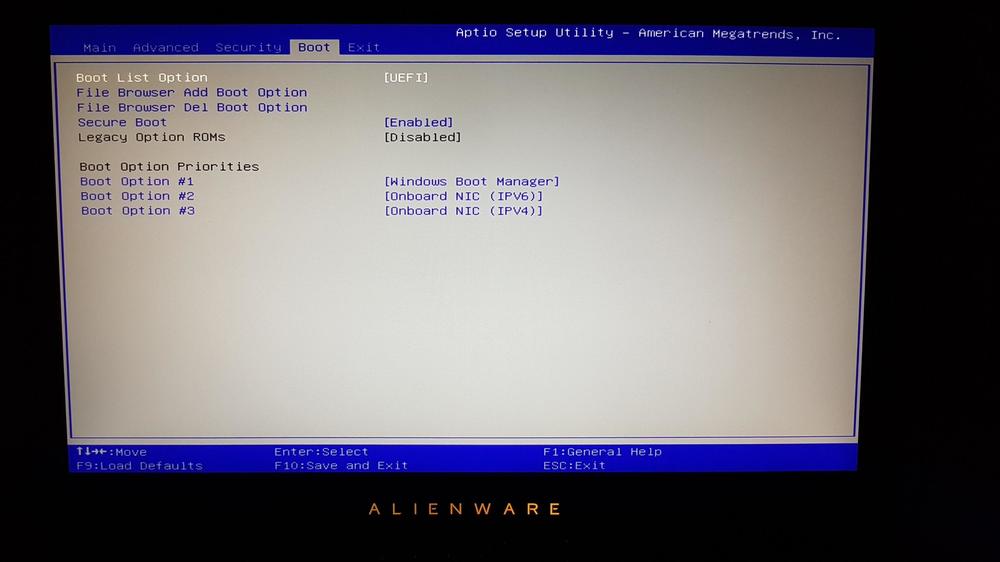

Ja, aber aus Erfahrung schließe ich mittlerweile nichts mehr aus. Wurde einfach zu oft schon eines besseren belehrt ?. Hatte auch schon mal ein Gerät hier, was einen ziemlich ähnlichen Fehler aufwies. Dort hatte vermutlich ein BIOS Update dazu geführt, dass der SATA Operation Typ (AHCI/ RAID on) umgestellt wurde. Dann lief zwar das BIOS, booten der Festplatte ging aber nicht mehr. Nach dem Umstellen ging dann wieder. Eine ähnliche Sache, die mir in dem Zusammenhang einfällt, welches ich schon öfter bei den AW-Repaste-Geräten gesehen habe, ist diese Meldung beim booten: Das System bootet zwar ins OS, jedoch nimmt diese Meldung beim Hochfahren immer Zeit in Anspruch. Auch hier resultiert die Ursache für dieses Problem durch falsch gesetzte Werte im BIOS, die scheinbar nach irgendwelchen Updates oder Hardware Änderungen (Tausch RAM/ SSD) aufgetreten sind. Lösung ist hier die Boot-Priorität zu ändern und zwar so, dass der Windows-Boot Manager an erster Stelle steht. Natürlich sofern Boot List Option auf UEFI steht. @marcohf78 @K54 hatte nicht einer von euch beiden, vor einiger Zeit diesen Punkt in der Area51m Lounge angesprochen?

-

Naja, solange das BIOS erstmal noch "betretbar" ist, kann man zunächst davon ausgehen, dass die Hardware in Ordnung ist. Wäre die (Notebook-eigene) Hardware beschädigt, äußern sich AW-Notebooks mit Leucht- und Beep-Codes in der Regel. Wenn natürlich die SSD einen Schaden hat, kann sich dein Problem so äußern wie du es beschreibst, Jingji. Kann aber auch genau so gut ein SATA/ NVMe Controller kaputt gegangen sein, der beim Laden der SSD Last bekommt und dann zu diesen Problemen führt. Da gibt's jetzt viele Möglichkeiten. Man kann versuchen das Problem höchstens einzugrenzen, was auf Distanz natürlich immer etwas schwer ist. Ansonsten kann ich mich vorerst nur den anderen Usern anschließen. Ins BIOS gehen, ePSA-Test durchführen und wenn alles nichts bringt, Gerät wegschicken.

-

Alienware Area-51m R1 Alienware Area-51m Laberthread & Owners Lounge

Sk0b0ld antwortete auf captn.ko's Thema in Erfahrungsberichte & Benchmarks

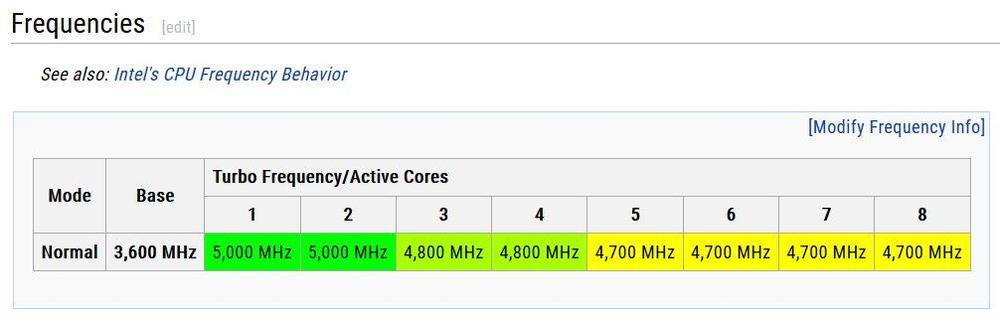

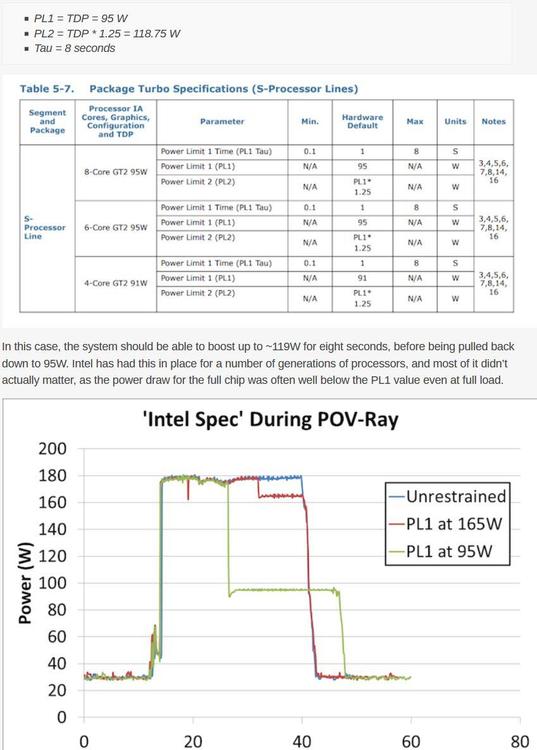

Nein, das ist nicht richtig. Du widersprichst dir schon wieder selbst. Bleib bei dem, was du gepostet hast. Du hast mit deinem Wikipedia-Link schon die richtige Definition gefunden. Zitat: "bei Intel gilt als TDP „die durchschnittliche Leistungsaufnahme (in Watt), die der Prozessor beim Betrieb auf Basisfrequenz ableitet, wenn alle Kerne bei einer von Intel definierten, hochkomplexen Arbeitslast aktiv sind".Über den maximalen Stromverbrauch bei anliegendem Boost-Takt, der weit über die Basisfrequenz hinausgehen kann, gibt es von keinem CPU-Hersteller eine Angabe." Basisfrequenz ist beim 9900K bei 3,6 GHz und das wird als Bemessungsgrundlage für die 95w TDP Angabe benutzt. Alles darüber hat nichts mit Intels TDP Angabe mehr zu tun. Alles Dinge nun schon mehrfach durch verschiedenen Quellen bestätigt wurden, inkl. deiner eigenen. -

Alienware Area-51m R1 Alienware Area-51m Laberthread & Owners Lounge

Sk0b0ld antwortete auf captn.ko's Thema in Erfahrungsberichte & Benchmarks

-

Alienware Area-51m R1 Alienware Area-51m Laberthread & Owners Lounge

Sk0b0ld antwortete auf captn.ko's Thema in Erfahrungsberichte & Benchmarks

CB R20 öffnen --> File --> Preferences --> und dann die gewünschten Einstellungen eingeben. -

Alienware Area-51m R1 Alienware Area-51m Laberthread & Owners Lounge

Sk0b0ld antwortete auf captn.ko's Thema in Erfahrungsberichte & Benchmarks

Wer so schnell antwortet, hat's sowieso nicht begriffen. Das zeigt nur deine Sturheit umso mehr. Wie immer weichst du meinen Gegenfragen aus. Ja gut, dann träum weiter, hör aber bitte auf Fehlinformationen zu verbreiten. Ist ja schließlich nicht das erste Mal von dir... Beispiel: -Link- @captn.ko, ich lass jetzt auch sein. Ist mir einfach zu anstrengend mit dem. Wer auf Ludo hört, ist dann halt selbst Schuld. edit @captn.ko Ich habe es versucht bestmöglich für jeden verständlich zu beschreiben. Selbst mit Quellenangabe, Bildern und und und, aber er will einfach nicht verstehen und hält krampfhaft an seiner Vorstellung fest. Das zeigt umso mehr wie sehr Ludo sich mit der Materie auseinandersetzt bzw. auseinandersetzen will. -

Alienware Area-51m R1 Alienware Area-51m Laberthread & Owners Lounge

Sk0b0ld antwortete auf captn.ko's Thema in Erfahrungsberichte & Benchmarks

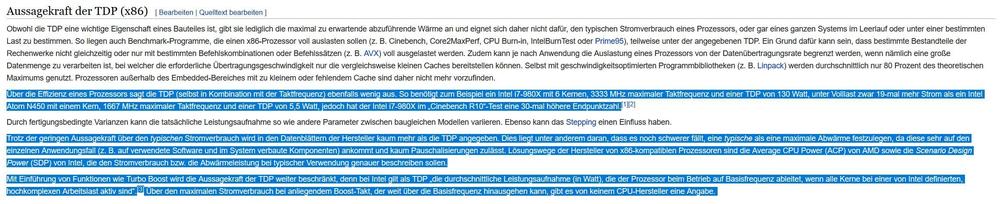

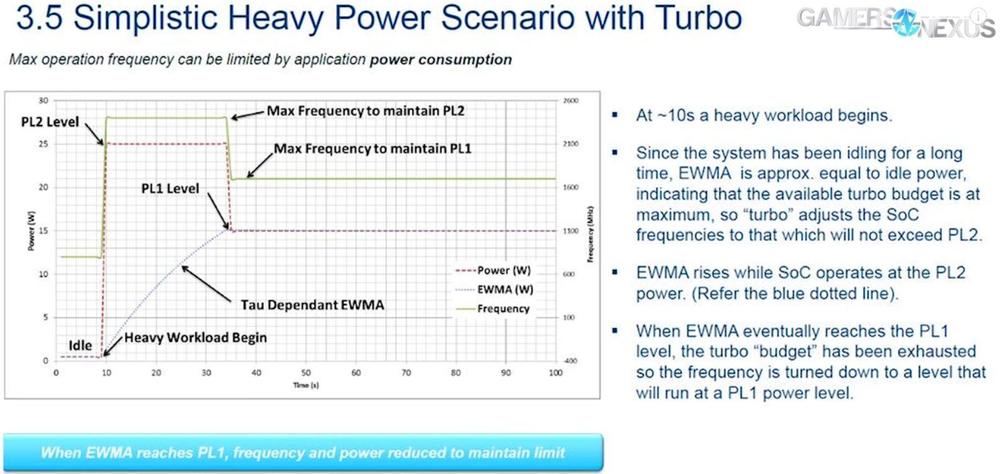

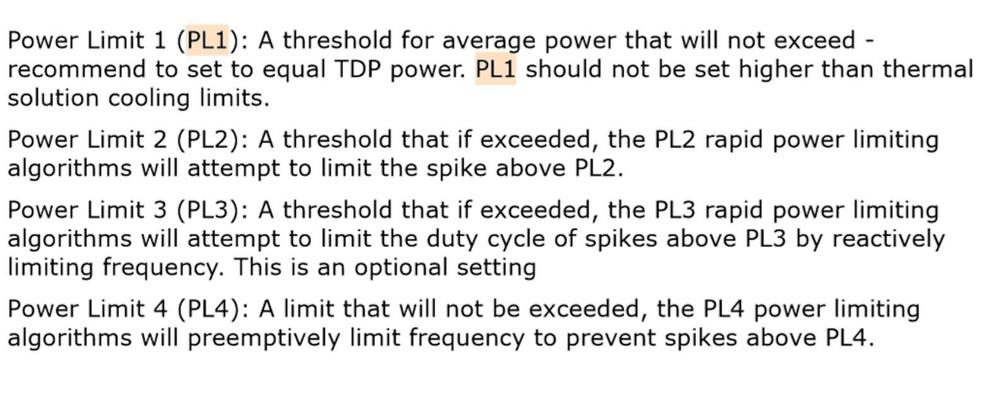

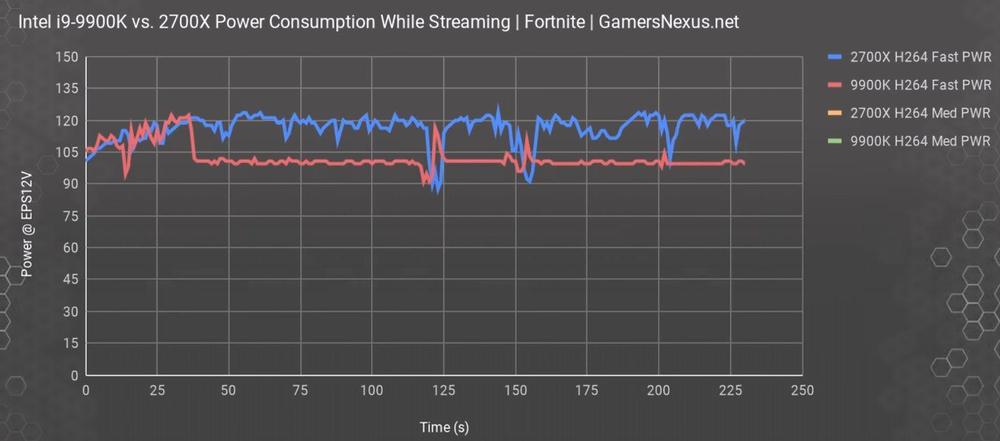

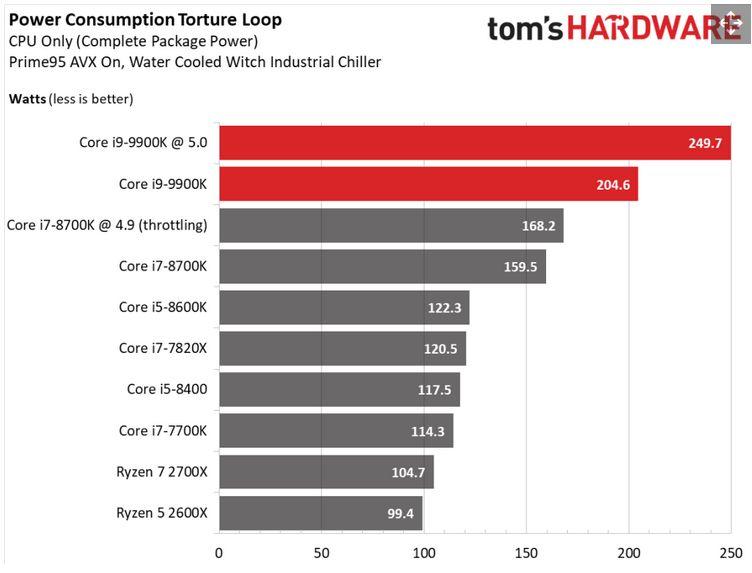

Ich habe selten so einen lernresistenten User wie dich erlebt, Ludo. Du scheinst absolut keine Ahnung zu haben wie sich die Intels spezifizierten 95w TDP überhaupt zusammensetzen und wie die Messung nach Intel überhaupt gewertet wird. Denn wenn du das wüsstest, würdest du nicht so einen Stuss schreiben. Punkt: Wasser oder Luft Wenn die CPU nur für eine Wasserkühlung wäre, wie du schreibst, würde sie ja gar nicht im Area51m zum Einsatz kommen. Also ist diese Aussage von dir schon mal Blödsinn. Es hat nichts damit zu tun mit was du kühlst, sondern wie viel Watt (TDP) du wegkühlen kannst. Mit was du das am Ende machst, bleibt dir überlassen. Dann der von Caseking angesprochene Punkt. Erstmal musst du ne AIO haben, die überhaupt besser ist als ein potenter Luftkühler. Ich habe mein Setup so abgestimmt und gemoddet, dass das mein Luftkühler selbst ne 280er AIO wegsteckt. Hat also nichts mit Wasser oder Luft zu tun, sondern wie viel Watt deine Kühllösung abführen kann. Diese Aussage ist auf so vielen Ebenen falsch.... Das würde ja also bedeuten, dass selbst wenn die Intel CPU sich durch Intels Power Environment Settings (Speed Step & Speed Shift Technology) auf 8x runtertaktet und kaum Strom verbraucht, die 95w aber, wie du es sagst, immer gegeben wäre. Das ist völliger Unsinn und natürlich auch völlig unrealistisch. Es gibt nämlich einen kleinen Unterschied zwischen maximal und immer. Punkt: "TDP gilt immer, egal WIE Du die CPU betreibst" 1. Schön das Abkürzungen und technische Daten der CPU kennst, nur solltest du auch verstehen was sie bedeuten, wenn du schon drüber sprichst. 2. Gelten die 95w TDP Verlustleitung für das Long Boost Power Window (PL1). Im Short Turbo Boost Power Window (PL2) (30 sek.) genehmigt sich die CPU deutlich mehr. Siehe Grafik: Quelle: Anandtech.com 3. Wie bereits gesagt, gelten die 95w nur, wenn du die CPU nach Intels Spezifikationen betreibst. In der Realität entscheidet das aber selten die CPU, sondern Mainboard, BIOS und VRM-Layout + Hersteller-Restriktionen ergeben die mögliche Leistung der CPU. Speziell im Notebook-Segment ist die Kühllösung noch ein weiterer Faktor. 4. Das dir die Abkürzung PL nicht geläufig ist, hast du letztens schon hier nachgefragt. Eine Abkürzung nicht zu wissen ist nicht schlimm, jedoch auf die Bedeutung pfeifen, obwohl ich dich drauf hingewiesen habe, ist was anderes. Daher wundert mich deine Argumentation hier nicht. Ich habe dir schon im Thread gesagt, dass die PLs darüber entscheiden, was sich die CPU erlauben darf. Glaubst du nicht? Gut, nehmen wir ein anderes einfacheres Beispiel und zwar meinem i7-8750H. Laut Intel hat die CPU eine maximale (nicht wie du sagst immer) TDP Leistung von 45w. Komisch das die CPU sich dauerhaft 75w im Long Term und bis zu 90w im Short Term genehmigen kann. Warum das so ist, siehe Punkt 3. Das ist auch der Grund, warum verschiedene Lüfterprofile verschiedene Leistungsstufen zulassen. Da das Thema scheinbar etwas kompliziert ist, hier noch mal eine kurze Zusammenfassung: 5. Betreibst du die CPU außerhalb von Intel Spezifikationen, kannst du dir die angebenden TDP Werte schenken. Dafür reicht schon ein passendes Setting im AWCC. Glaubst du nicht? Dann stell die Lüfter auf 100% und lass CB R20 im Loop laufen. Dann wirst du ganz schnell sehen, was deine CPU von der angegebenen TDP Leistung hält*. Selbst beim "normalen" OC mit 5,0 GHz genehmigt sich die CPU weit über 200w. *edit, keine Ahnung was die Limits beim non-K Modell sind. Hast du dich überhaupt schon mal gefragt warum das so ist? Ist dir eigentlich klar, dass du dich mit der Aussage selber widersprichst? Oben schreibst du, dass 95w immer gegeben ist, aber UV dann doch was bringt. -

Alienware Area-51m R1 Alienware Area-51m Laberthread & Owners Lounge

Sk0b0ld antwortete auf captn.ko's Thema in Erfahrungsberichte & Benchmarks

Erzähl nicht wieder so'n Quatsch. Ist sie nicht. Selbst mein KS läuft bei 5,3 GHz all Core problemlos auf Luft. Die TDP Angabe ist nur relevant, wenn du die CPU nach Intel Spezifikation betreibst. -

Danke für den Hinweis. Wusste selber gar nicht, dass das Thema bereits existiert. Werde mich heute Abend ran machen und die Beiträge verschieben.

-

Alienware Area-51m R1 Aus 2 mach 1 Netzteil

Sk0b0ld antwortete auf Elite10's Thema in Anleitungen & How To

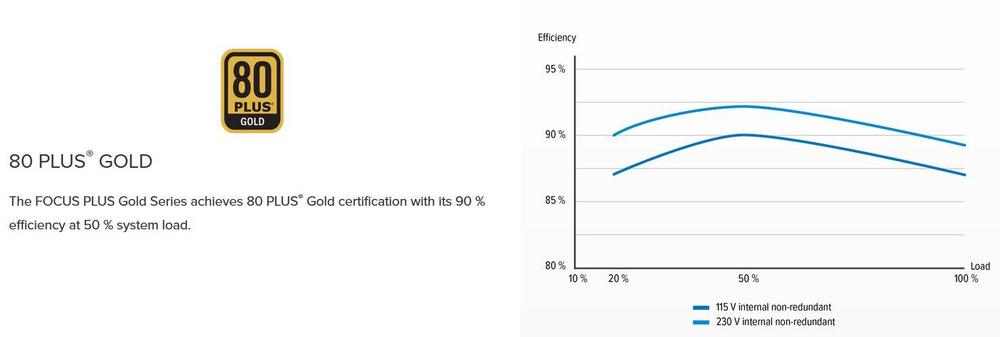

Mal ne Frage, hast du auch schon mal selbst nachgemessen oder ist das wieder nur pauschale Aussage, die sich auf eine Willkür von verschiedenen Netzteilen betrifft? Natürlich hat die Wandlung von Strom immer was mit Verlust zu tun. Das lässt sich nicht vermeiden wenn du von 230/ 115V AC auf 19,5V DC transformierst. Und gerade das 330w NT von Delta Electronics ist kein super effizientes 80 PLUS Ultra Titanium bla bla bla Netzteil, sondern aus heutiger Sicht eher als veraltetes bzw. "nicht so effizientes" Netzteil einzustufen, zumindest wenn man es mit den PSU's aus dem PC-Bereich vergleicht. Zum "kaum Verluste" noch ne Anmerkung. Selbst 80+ Gold Netzteile haben die beste Verlustleitung = höchste Effizienz bei 'nem Load von ca. 50%. Befindest du dich drunter oder drüber erhöht sich die Verlustleitung deutlich und wir sprechen hier von einem relativ modernen Netzteil. Da ist das 330w Notebook NT noch weit von entfernt. Ich habe mir das ganze natürlich nicht nehmen lassen und selbst mal ein bisschen nachgemessen. Hab verschiedene Benchmarks gleichzeitig laufen lassen, Spiele usw. Alles aufgedreht was geht, um zu gucken, was das Netzteil aus der Wand zieht und was tatsächlich davon in Leistung (CPU & GPU Package Power) verbraten wird. Bei FarCry 5 (mit den höchstmöglichen Settings) schwankte der Stromzähler dabei zwischen 270w und 305w, also das was tatsächlich aus der Wand gezogen wurde. So sah das Resultat dann aus. Ca. 300w aus der Wand gezogen und ca. 230w davon als Leistung im Notebook umgesetzt. Jetzt erkläre mir mal bitte wie du auf "kaum Verlust" kommst? Wenn du aus dem Netzteil 2-3h dauerhaft 250-280w rausziehst, dann wird er auf jeden Fall ziemlich warm. -

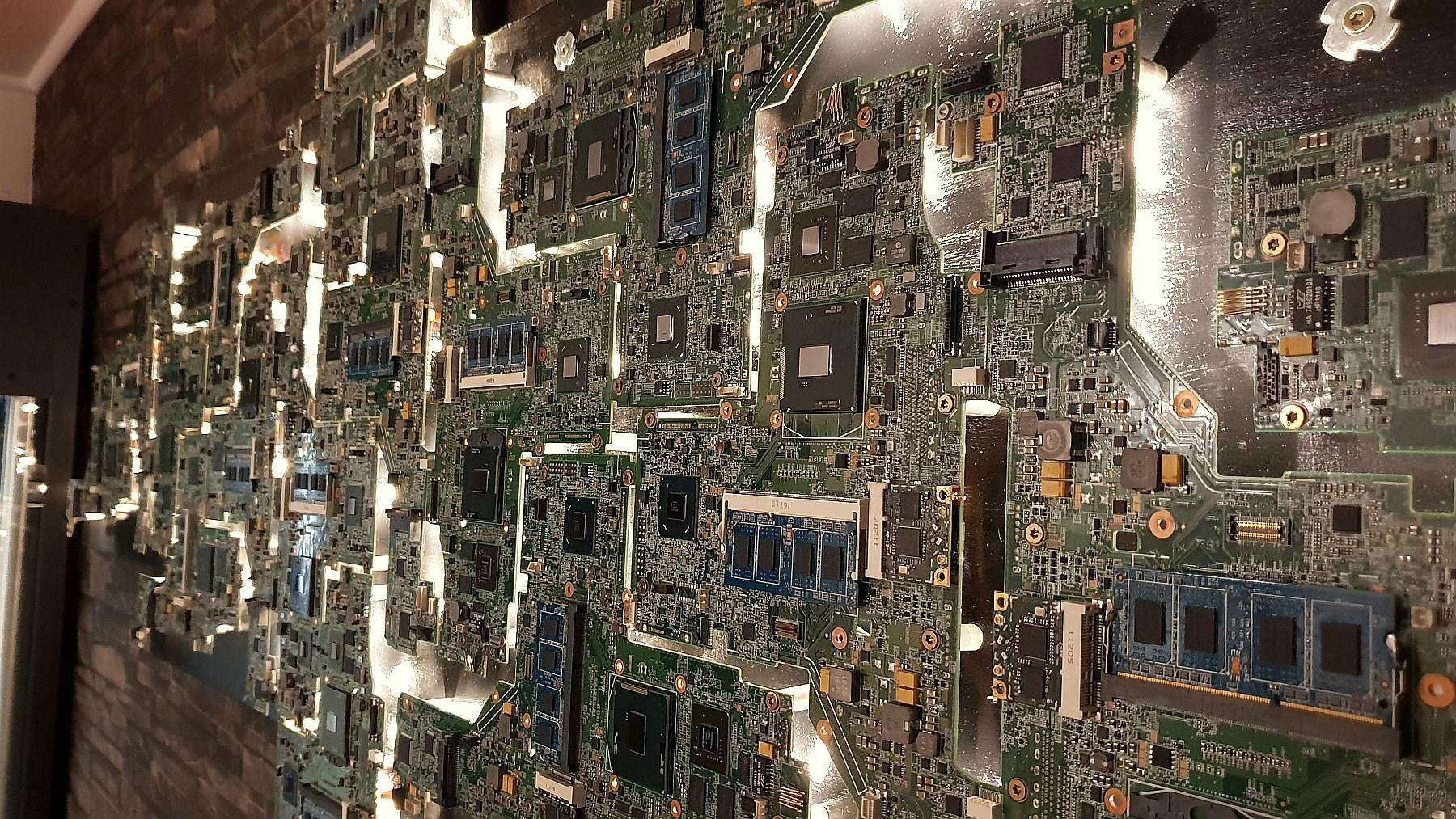

und wie groß fällt der Unterschied aus? Zumindest zu der Zeit, wo ich nur AW-Notebooks hatte, sah mein Setup lange Zeit so aus: Ich hatte auch schon mal in dem ein oder Thread darüber berichtet (Hardware-Deko / Kabelsalatlösung), was das ganze Zeug auf den Bildern angeht. Mittlerweile steht der Lappy mit Monitor, Tastatur usw. in meinem Büro (nutze ich mehr zum arbeiten) und der dicke Desktop PC mit zwei Monitoren im Wohnzimmer. Bei Gelegenheit lege ich ein paar Fotos nach.

-

Alienware Area-51m R1 Kurze Frage zwecks Temperaturen GPU/CPU

Sk0b0ld antwortete auf SpecialAgentFoxMulder's Thema in Allgemeines & Troubleshooting

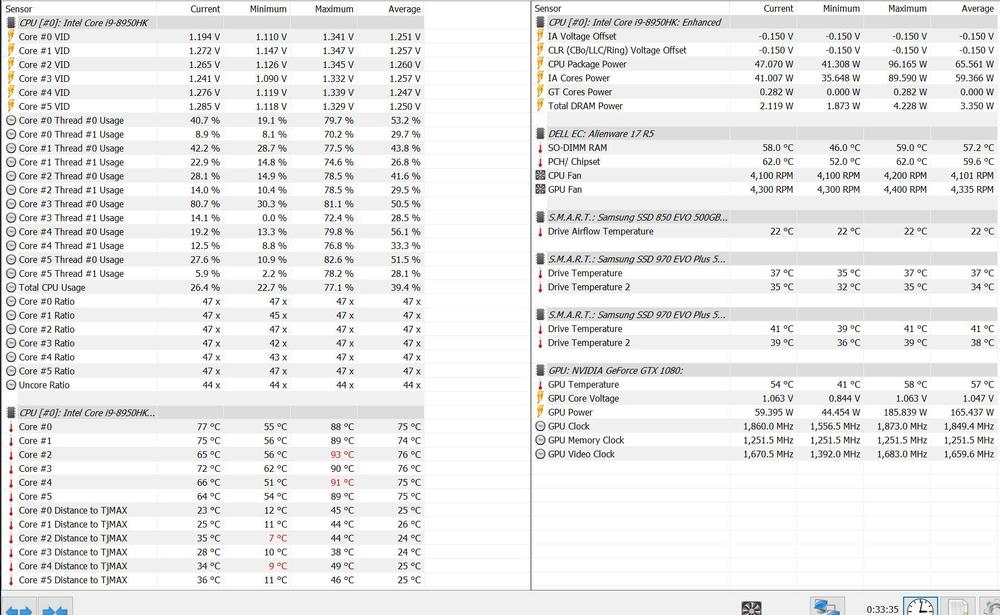

Mit so einer Aussage kann wenig anfangen. Wenn du 2h gespielt hast und die CPU in dieser Zeit nur einmal an die 94°C im max. kam, hat das ja nicht wirklich was mit dem Gesamt-Kühlleistung zu tun. Es fehlen einfach zu viele Informationen, um das bewerten zu können. Da das Thema vor kurzen schon mal aufkam, kopiere ich mal den Teil mit dem Bewerten der Kühlleistung: -Link- Lies dich mal ein und stell HWinfo mit den genannten Werten übersichtlich ein und poste ein Screenshot. Dann kann man viel besser Rückschlüsse ziehen wie deine Kühlleistung ist und überhaupt Handlungsbedarf besteht. -

Nichts für ungut, aber ändere mal bitte den Titel in etwas um, mit dem man auch was anfangen kann. Z.B. "Wie sieht euer Setup aus" oder so ähnlich. Ich will hier nicht der Spielverderber sein, nur sind so spaßige Titelbeschreibungen äußerst nervig und wenig hilfreich, wenn man in Zukunft später mal, in den Unterforen bestimmte Themen durchsucht.

-

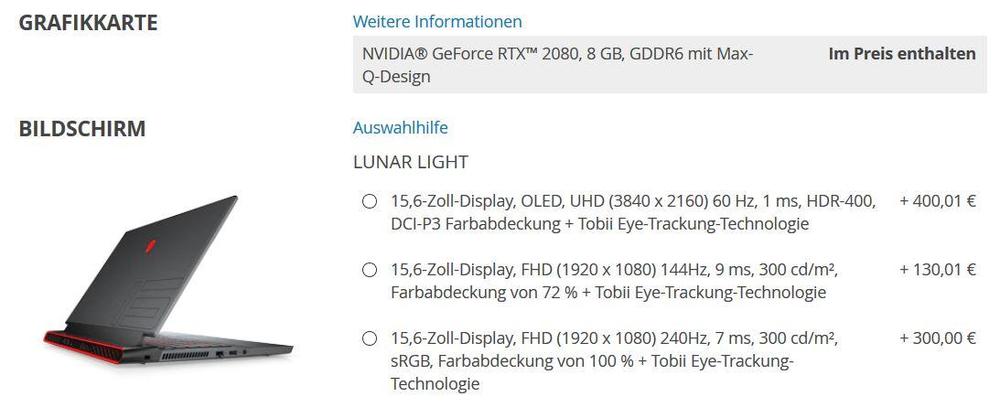

Wir brauchen uns nicht einigen, wenn es bereits vordefinierte Standards gibt: Full High Definition/ FHD - 1920 x 1080p Quad High Definition/ QHD - 2560 x 1440p Ultra High Definition/ UHD (4K) - 3840 x 2160p Was ich nicht ganz verstehe, du hast nun mehrfach hier im Forum erwähnt, dass du mit Programmieren deinen Lebensunterhalt verdienst (Beispiel): Verteufelst aber jede Auflösung, die höher ist als FHD und stellst es als sinnlos oder unnötig dar... Vergleiche ich deine Aussage, mit der Aussage eines bekanntes Programmierers (über 15 Jahre Erfahrung), macht das für mich irgendwie gar keinen Sinn. Denn Josh (so heißt der Typ) empfiehlt, sofern es die Konfiguration und der Geldbeutel zulässt, ein helles, hochauflösendes 4K-Panel. Natürlich sind auch moderne FHD Panel zum coden geeigent, jedoch zieht er das 4K-Panel immer vor. Was das ganze andere Zeug angeht, hatte ich dir ja bereits gesagt, dass der Ton die Musik macht. Wenn du deine eignen Präferenzen hast, ist das ja vollkommen in Ordnung, nur sind so allgemeine Aussagen wie "4K macht keinen Sinn" nicht unbedingt vorteilhaft, wenn du den Anwendungsbereich von UHD Panels in Notebooks nicht kennst. Jeder hat andere Ansprüche an das Notebook und dementsprechend fällt das Display/ die Auflösung mehr oder weniger ins Gewicht. Vielmehr solltest du dich fragen, warum die meisten Hersteller überhaupt diese "relativ teure" Option seit vielen Jahren anbieten.

-

Wir haben es verstanden, hat aber nichts mit der objektiv betrachteten Hardware-Situation zu tun. Das mit dem "erst gar nicht danach geschaut" musste ich bei dir leider schon mehrfach feststellen. Außerdem geht's um UHD und nicht QHD Panel, aber das nur am Rande. (siehe Überschrift des Themas) Nein, das Modell wird mit den Displays beworben mit den man es ausstatten möchte. Du hast freie Wahl. Siehe Bild (in der Hoffnung das du es dir anschaust)

-

siehe meinen vorherigen Beitrag, drittes Bild. Wer lesen kann ist klar im Vorteil. Ich geb's auf... Captn.Ko hat mich schon drauf hingewiesen. Dein Beispiel hat nichts mit den Notebooks zu tun und ist auch nicht vergleichbar in dem Kontext wie du ihn schilderst. Bei den UHD Panels geht's nicht um die Auflösung alleine. Es ist auch nicht alles super winzig oder so. Keine Ahnung, was du dir da so vorstellst. Beschäftige dich mal mit der Hardware mehr, dann siehst du auch warum 4K Panel überhaupt gekauft werden und eine Daseinsberechtigung haben. Würden die sich nicht verkaufen, würde die Hersteller sie auch nicht anbieten. Angebot und Nachfrage. Scheinbar gehst du nur von deiner eigenen Sichtweise aus und alles andere ist nicht klug (= dumm) oder macht kein Sinn in deinen Augen. Was deine Frage in der Ausführung angeht: Auf'n Nürburgring oder beispielsweise auf dem Motorsportgelände in Oschersleben kann man sich wunderbar mit solchen Autos austoben. Vorausgesetzt, das man "Spaß haben" und "sinnvoll" in einen Kontext setzt. Jeden weiteren Kommentar, der nichts mit dem Thema zu hat, wird direkt gelöscht. Das du bescheid weißt. Deine Ausschweifungen in irgendwelche anderen Gebiete haben nichts mit dem Thema oder dem Inhalt des Forums zu tun.

-

Alienware m17 R2 Lautsprecherleiste Alienware M17 (2019) gebrochen

Sk0b0ld antwortete auf PsyClopes's Thema in Allgemeines & Troubleshooting

Das kann man vorher nicht wissen. Am besten du rufst an und versuchst jemanden an's Telefon zu bekommen, der sich mit dem Ersatzteilkatalog auskennt. Die haben alle Geräte in der Ersatzteil-Software auch als Explosionszeichnung da und können fast jedes Ersatzteil einzeln rausfinden und wenn du Glück hast auch liefern. Jedoch ist das bei manchen Teilen so, dass sie nur lieferbar als ganzes Stück sind. Bedeutet also, dass das angefragte Ersatzteil aus mehreren einzelnen Teilen besteht und dann wird's natürlich auch teurer. Alternativ könntest du das gebrochene Teil auch ausbauen und gucken ob die gesuchte Teile-Nr. drin steht. Die gehen immer los mit DP/ N: und dann die Nummer. Diese DP/N Sticker sind fast auf jedem Bauteil zu finden.

.thumb.jpg.5df75e1cd7ef97d7cb3a754ec8a1426c.jpg)