-

Gesamte Inhalte

836 -

Benutzer seit

-

Letzter Besuch

-

Tagessiege

38

Inhaltstyp

Profile

Forum

Kalender

Downloads

Treiberreihenfolgen

Alienware Geräte-Lexikon

Alle Inhalte von Robman

-

Hätte das Razer doch nur bessere Lüfter... ich finde die soo hochfrequent, auch bei 2300 RPM o. ä. (hatte schon zwei 17er hier...). Ich hatte sogar die zwei vorderen Lüfter (hat ja insgesamt vier) abgesteckt, das Hochfrequente kam aber leider nicht von diesen. Ich mag aber einfach auch dickere Geräte mit Desktop-CPU. Schade, dass das Area 51m R3 scheinbar morgen noch nicht vorgestellt wird.

-

Ja, das Area 51m ist eigentlich alternativlos. Glücklicherweise gefällt es mir auch optisch. Andere DTRs sind dicker und nicht unbedingt besser hinsichtlich Leistung udn Temperaturen. Wollen wir hoffen, dass die GPU mindestens 150W haben wird und als Display auch QHD oder UHD mit 120+ Hz angeboten wird.

-

Das liegt aber auch daran, dass die RTX3000-Desktop-Karten mehr ziehen als noch die RTX2000-Desktop-Karten. Eine 2080 hatte typischerweise 250W. Die 3080 hat typischerweise 320W. Diesen Sprung konnte man im Notebook eben aufgrund der noch gleichen Kühllösungen nicht machen.

-

Ja, das wird bestimmt mindestens 150W haben, zudem bestimmt eben wieder eine Desktop-CPU (mehr Takt, mehr Cache usw.) Bin sehr gespannt, übermorgen wissen wir hoffentlich mehr.

-

Ok, dann kaufst du es wirklich nur weil du was Neues haben möchtest. 😄

-

Hab auch mal ein GE76 (mit 3080) bestellt, ist aber echt teuer und bietet ja auch nur FHD und kein G-Sync (aber halt dafür 300 Hz) - kommt für mich eigentlich nicht in Frage. Aber mal schauen - mich interessiert jetzt erstmal einfach nur die Qualität und die Geräuschkulisse. Die meiste Hoffnung mach ich mir aber noch beim Area 51m R3 (QHD oder UHD mit mindestens 120 Hz, G-Sync...). Ja, klar.

-

Das hört sich gut an, danke! Dann warte ich mal 3 Tage.

-

Hi zusammen, mein Desktop ist schön und gut (5900x, 3090), aber zwei Notebooks statt ein Desktop + Notebook bieten noch mehr Flexibilität. Zudem ist der Energieverbrauch im Verhältnis zur Minderleistung (wie gewohnt) viel besser. Ergo ich möchte ein Ampere-Notebook. Die 3080 soll es sein (Desktop 3070 Leistung soweit ich gesehen habe), um noch so einige Titel in UHD@60 fps spielen zu können. Die Leistung im Vergleich zur 3090 fällt durchschnittlich wohl um 1/3, dafür locker halbierter Energieverbrauch. Wie immer halt ungefähr. Des Weiteren muss es ein UHD 120 Hz oder QHD 120+ Hz Display sein. Und 17 Zoll. Und möglicht nicht so dünn wegen Optimierung der Lüfterlautstärke (Razer kommt schonmal nicht in Frage). Was gibt es da so? MSI GE76 lese ich hier (sieht auch ganz gut aus). Was sonst noch? Das Asus Rog gefällt mir optisch nicht. Alienware kommt wohl wegen Display nicht in Frage (echt schwach von Alienware/Dell...). Bin die Tage mich jetzt erst am einlesen/recherchieren... bin in der Notebookwelt einige Zeit abgetaucht gewesen... Danke & Grüße

-

Viel Spaß damit. Mir persönlich ist diese Karte zu übertrieben und zu teuer. Ich finde 350W mit 2x8 Pin reichen völlig, und durch mein Undervolting erreicht meine GPU nie mehr als 314W. FPS habe ich kaum weniger. 400-500W bringt kaum mehr fps, bedarf aber deutlich mehr Kühlung bzw. bekommt man nur leise mit ordentlicher WaKü hin. Steht aber aus Prinzip für mich in keinem Verhältnis (Mehrleistung zu Mehrverbrauch). Ist aber sinnvoll, wenn man in Benchmarks möglichst viele Punkte haben möchte.

-

Meistens 10-15%. Und in manchen wenigen Spielen sind es 20-25%, z.B. in Breakpoint. Zukünftig werden es sicher noch mehr Spiele, wo der Uplift zur 3080 mehr als 10-15% hoch ist. Es kann also durchaus, gerade für UHD-Gaming, den Unterschied machen. Es kommt aber natürlich auch aufs Budget an, für die meisten ist sicher eine 3080/6800XT sinnvoller, ja. Am sinnvollsten (auch wegen DLSS) wird wahrscheinlich eine 3080 TI mit 16 GB VRAM sein. Bei AMD muss man erst abwarten, wie gut Super Resolution wird. Aber wie mein Vorredner schon sagte, wird die 3080 Ti auch nicht günstig, wenn auch etwas günstiger. Aber man darf gegenüber der 3080 Ti und auch 6800/6900XT eins nicht vergessen: die 3090 war schon die ganze Zeit mehr oder weniger gut verfügbar.

-

Ein CPU-Limit kann auch vorliegen, wenn die Last bei 50% ist bzw. selbst wenn einzelne Kerne bei 70-80% sind. Aber 90-100% auf der GPU ist relativ eindeutig. Und dann gibt es ja auch noch komische Engines. Ich kann zu Cyberpunk noch nicht so viel sagen, weil ich es noch nicht viel gespielt habe. Ich spiele es bisher mit DLSS Ausgeglichen und deaktiviertem Raytracing (und es stehen auch nicht alle Details auf Ultra), daher hab ich eigentlich immer zwischen 80 und 117 fps (mein Limiter).

-

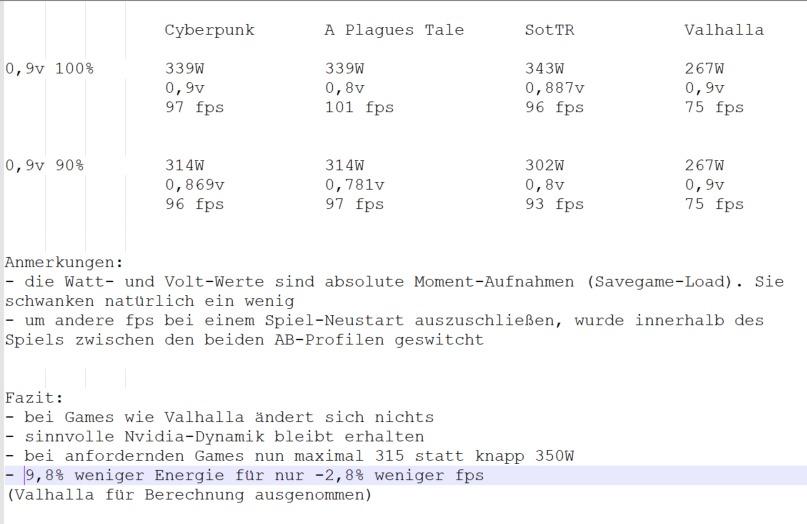

Neues Update 😂 Seit einigen Tagen nutze ich nun folgende Settings: manuelle Afterburner-Kurve (also ein individuelles OC pro Taktstufe, bei rund 0,8v z.B. mehr Mehrtakt als bei 0,9v, logisch) cap bei 0,9v (das Verhältnis von Mehrtakt zu Mehrverbrauch wird mir oberhalb 0,9v einfach zu schlecht, zudem mit maximal 0,9v weniger coil whine) Powerlimit von 100% auf 90% reduziert, das realisiert in heftigen Games nur maximal 315W statt 34XW. Und in weniger lastigen Games hinsichtlich des Verbrauchs wie z.B. Valhalla verliert man keine fps, weil die 0,9v bei unter 300W nach wie vor gehalten werden können drei Spiele (Cyberpunk, A Plagues Tale, SotTR) getestet: 90 statt 100% PL bringt 9,8% weniger Energie/Watt, bei nur 2,8% fps-Verlust Und selbst wenn es 3-4% wären (viel mehr Spiele testen) wäre das für mich noch ok die Kombination aus manueller Kurve, cap bei 0,9v sowie gleichzeitige Reduzierung des PLs ist für mich bzw. meine 3090 nun das Nunplusultra zwischen Energieeffizienz und wenig fps-Verlust. Ich kann mir nicht vorstellen, dass ich dieses Setup nochmal ändern werde 😉 Die 6900XT habe ich übrigens nicht versucht zu bestellen, da sie weniger Leistung hat als erwartet. Insofern bleibt die 3090 meine GPU für die nächste Zeit.

-

Muss ich nochmal richtig stellen. Das Fahrzeug in der Stadt fährt sich wieder okay. War nur das Fahrzeug am Anfang außerhalb bei den Nomaden.

-

Da kann ich nur zustimmen. Bin aber bisher erst ein Auto gefahren (aber ich denke das reicht...).

-

Wenn der Preis wichtig ist dann am besten eine 3080 Ti mit 16 GB VRAM und keine von beiden genannten. Ich werde mir jedenfalls keine 6900XT bestellen (hatte ich ja erst vor), sie ist mir doch in zu vielen Titeln zu viel langsamer (in UHD) als meine 3090. Und SAM bzw. unter anderem Namen wird es auch für Intel + Nvidia oder auch für AMD + Nvidia kommen. Ist ein einfach zu implementierendes PCIE-feature, was nun jeder machen wird. Sprich bald hat man hier und da auch nochmal paar % mehr fps mit einer 3080 / 3090. Die 6900XT ist auch nicht in allen Titeln großartig energiesparender (im Verhältnis zur Leistung) als die 3090. Aber egal, ich will / brauche für mein UHD Gaming eh das Beste, und das ist und bleibt die 3090 (ja, deutlich teurer).

-

Ich muss leider schon wieder ein Update geben, diesmal aber glaube ich ziemlich final... für die frametimes ist es einfach das Beste (schreibt auch igorslab.de), mit der GPU gar nicht erst ins PL zu kommen. Bin daher wieder wie vorher (und auch wie bei meiner 2080 Ti) bei einem fixen Takt und einer fixen Spannung, wo ich auch in heftigen Games eben nicht das PL erreiche für mich immer noch schnell genug bzw. in Games kaum weniger fps (bei maximal 117 Ziel-fps, die ich spiele) die Lüfter sind natürlich nochmals leiser Coil Whine nicht mehr zu hören (wenn man das Ohr direkt dranhält dann natürlich schon) mein Netzteil freut sich (weniger Watt im Durchschnitt und auch weniger Lastspitzen) So lass ich nun die 3090 in meinem kleinen Case! Als nächstes wird dann (auf vergleichbare Weise) die 6900XT getestet und dann ist mal (zumindest bei mir) wirklich gut mit irgendwelchen Optimierungsgeschichten. Muss mehrere Spiele noch zu Ende spielen...

-

Bleib bei der einfachen Variante... alles andere ist schon etwas mühsam. Meine 0,8v bei 1800 MHz waren jetzt am Ende doch nicht stabil. Etliche Stunden und Tage in Spielen getestet. Aber der Metro Exodus Benchmark ist abgestürzt (hab mir das Spiel nun ma geholt)... also nicht stabil... Ich hab daher seit gestern Abend folgendes (einfaches und schnell einzurichtendes) Setup aktiv: 100 MHz Core OC 248 MHz VRAM OC (glatte 10000 MHz) gekappt bei 0,9v (reicht allgemein, auch wegen Rasseln & Co., außerdem könnten obenrum +100 MHz dann auch zu viel sein) Ich habe nun damit stabil etliche Durchläufe in Metro Exodus gemacht (egal ob mit DLSSS und/oder RT) und außerdem Valhalla so einige Zeit gespielt. Dieses Spiel lässt wie kein anderes sehr hohe Spannungen / Taktraten zu. Beide Extreme laufen soweit stabil, aber bei +100 und cap bei 0,9v mit vielen Karten auch nicht verwunderlich. Und um 50 MHz mehr geht es mir jetzt nicht mehr. Stabile zu 100% ist das Wichtigste. Bei Metro oder anderen heftigen Games liegen jetzt eben 1725-1770 MHz an. Für mehr reichen die 350W halt nicht. Bei vielen anderen Spielen eben zwischen 1800 (nun hier natürlich mit mehr als 0,8v) und 1890 MHz. Und bei Valhalla und ähnlichen wenigen Spielen, die nicht viel Watt ziehen, liegen eben die fixierten 0,9v bei 1890 MHz (halt wie gesagt stock-Kurve + 100 MHz) bei 70 Grad an (mehr Temperatur lässt meine Lüftersteuerungs-Config bewusst nicht zu. Noch leise genug mit meinen Noctua-A12. Mehr als 70 Grad könnte theoretisch mit +100 MHz auch wieder nicht stabil laufen, logisch - umso heißer umso weniger Stabilität und er Theorie). Mit dieser Vorgehensweise ist man natürlich deutlich schneller mit einem UV-/OC-Setup fertig und macht zukünftig kein großes Thema mehr draus. In meinem Fall gar nicht so schlecht, weil man doch einige Zeit in Config & Tests absolviert hat. Irgendwie schon zu viel, da zocke ich zukünftig mal lieber was. Zudem möchte ich ja auch noch die 6900XT testen. Mal schauen wie die abliefert und ob sie dann weniger Energie benötigt (wahrscheinlich). Zudem würde sie gut zu meinem 5900X passen, auch wenn mir sowas egal ist. Aber kritisch sehe ich den DLSS 2.0 Pendant... mal abwarten... mit ner 3090 hat man es natürlich nicht eilig.

-

Ich habe den Desktop erst vor kurzem zusammengebaut, er ist noch nicht final "schön". Bilder dann gerne zu einem späteren Zeitpunkt. Die Noctua A12x25 Lüfter, die zwischen 1000 und 1400 RPM (das ist sehr leise bei diesen Lüftern) drehen, sind aktuell mit Kabelbinder an der GPU befestigt. Das ist pragmatisch, aber nicht elegant. Die CPU-Kühlung des 5900X mit dem be quiet Dark Rock TF (Silent Wings 3 130er bei rund 950 RPM konfiguriert sind dort drauf) ist noch nicht so optimal. Ich warte aktuell darauf, dass Noctua den U12A in schwarz releast, das wird laut Roadmap irgendwann in Q1/21 sein. Dann werde ich auch die aktuell braunen A12x25 auf der GPU durch schwarze ersetzen. Dann habe ich quasi alle Lüfter einheitlich von Noctua (alles A12 - sensationelle Lüfter, sowohl von der Leistung, Druck, als auch von der Geräuschcharakteristik). Oben als Gehäuse-Lüfter nutze ich zwei A12x15. Drehzahl um die 950 RPM, sehr leise. Das wars auch schon, das Cooler Master NR200 ist nicht grade groß (18 Liter). Bei Valhalla habe ich geringere Temperaturen als in Spielen wie z.B. Division 2 oder A Plagues Tale. Grund ist, dass die Assassins Creed Reihe die Nvidia Karten irgendwie nicht voll auslasten. Und die CPU-Temperatur ist hier auch relativ gering, beides unter 70 Grad. Vollem die CPU ist hier glaube ich nur bei maximal 65 Grad. OC nutze ich im Prinzip gar nicht. Ich nutze nicht mehr als 1905 MHz @0,9v (bei gleichzeitigem Undervolting). Bei heftigen Spielen liegen noch 1800 MHz @0,8v an. Hintergrund ist mein 350W Powerlimit. Die 6900XT werde ich denke ich testen. Mich reizt der wahrscheinlich niedrigere Energieverbrauch. Raytracing nutze ich nicht. Jedoch setze ich auf DLSS 2.0 und ich glaube nicht, dass AMD da großartig gegen anstinken wird, man wird sehen. Und dann wären da noch die Treiber usw., Nvidia hat hier einfach einen Vorsprung. Gut möglich, dass ich die 3090 daher behalte. Die Mehrkosten spielen für mich am wenigsten rein - mir muss das Ganze einfach gefallen.

-

Du musst mal auf den Speichertakt achten, am besten in Echtzeit per OSD ingame bei lastigen Games. Gut möglich, dass der sich nämlich runtertaktet, weil er zu heiß wird. Dann bringt dir das OC in dem Moment natürlich gar nichts (was aber halb so schlimm wäre). Gerade weil du 400 statt 350W nutzt (Karte wird also heißer) und außerdem soll die FE, genauso wie z.B. die MSI Gaming X Trio, nicht so ideal sein für Speicher-OC (laut igorslab.de). Der Speicher bei der 3090 ist halt auch allgemein schon sehr hochgezüchtet.

-

Du hast sicher ein einfaches OC von 75 MHz gemacht? Hier verschenkst du wie gesagt Leistung bei Spielen, die bereits das PL früher vollbekommen. Bei dir dürfte es aber nicht so tragisch sein, da du ja 400 statt 350W zulässt. Meine GPU kommt nicht über 70 Grad, meine Lüftersteuerung ist entsprechend so eingestellt. Bei längerer Volllast liegen 69 (manchmal für paar Sekunden 70) Grad an. FPS müsste ich nachreichen. Grundsätzlich nutze ich keine vordefinierten Ingame-Grafik-Presets. Ich mach mir immer individuelle Grafikstellungen, hier lassen sich meistens noch ein paar fps rausholen, ohne dass man einen Unterschied in der Optik bemerkt.

-

Ich muss da jetzt nochmal was ergänzen: Noch sinnvoller ist es, sich die Mühe zu machen, die Afterburner-Kurve komplett von vorne bis hinten anzupassen (und nicht bei 0,8v oder 0,9v zu cappen - also eine Dynamik wie die Stock-Kurve zu haben, nur natürlich mit mehr MHz pro Spannungspunkt). Ist aber Arbeit, da ein OC bei 0,8v viel besser funktioniert als bei 0,9 oder gar über 1,0v. Konkret: bei 0,8v sind bei mir +195 MHz kein Problem, um noch stabil zu laufen. Bei über 1,0V reden wir von unter 100 MHz, klar. Ich habe mir jetzt mal die Mühe gemacht, und die Kurve komplett von vorne bis hinten angepasst und durchgetestet. Wieso? Weil es Spiele gibt, konkret Assassins Creed Walhalla (und auch die Vorgänger), die mein PL von 350W selbst mit der Maximalspannung von 1,081v nicht vollbekommen. Bei dieser Spannung kann ich meine Karte mit bis zu 2085 MHz betreiben (+75 MHz gegenüber stock, mehr macht keinen Sinn zu testen, da selbst solche Spiele nicht dauerhaft 1,081v anlegen, sondern meistens um die 1,044v mit 2025-2055 MHz). Was bringt es? Statt 1800 MHz@0,8v liegen bei Valhalla nun wie gesagt in meinem Fall bis zu 2085 MHz (meist 2025-2055 MHz) an. Das entspricht einem Mehrtakt von bis zu 14% gegenüber den fixen 1800 MHz. In Mehr-fps bleiben im Schnitt noch leicht über 7% davon hängen, was statt 68 fps im internen Benchmark bei 4k (das Spiel ist mega heftig) 73 fps bedeutet - das ist natürlich ordentlich / lohnt sich. Ja, alle die ein einfaches OC gemacht haben, haben diesen Vorteil bereits auch schon. Aber: bei heftigen Spielen, wo bereits bei 0,8v das PL von 350W vollläuft (z.B. A Plagues Tale), ändert sich halt nichts. Hier liegen nach wie vor 1800 MHz an (+195 MHz gegenüber stock). Wer jetzt nur ein einfaches OC von z.B. 75 MHz gemacht hat, hat bei weitem keine 1800 MHz bei 0,8v anliegen... (zumindest nicht mit dem 350W-Standard-PL). Und bei den Spielen (die allermeisten übrigens) die irgendwo dazwischen liegen (Hitman 2 oder Ghost Recon Breakpoint z.B. 0,8X-0,9Xv), liegen eben noch bis zu 1920 MHz in meinem Fall an. Spulenfiepen ist für mich übrigens kein Thema, erstens habe ich eine sehr leise Karte erwischt (hab drei MSI Ventus getestet, alle ähnlich leise und deutlich leiser als die FE - wie hier schonmal irgendwann gesagt) und zweitens steht mein Desktop in einem großen Wohnzimmer (ist aber parallel auch mit einem Monitor / Nebenraum über lange Kabel verbunden). Außer einem leisen Rauschen der Noctua A12 höre ich (und nur wenn es ruhig ist) von meinem Desktop nichts (anders sähe es aus, wenn noch die Standardlüfter auf der 3090 drauf wären... ;)). edit: Man kann das ja auch gut kombinieren. Man lässt die Kurve so (bei geringen Spannungen mehr OC als bei hohen) und cappt aber bei 0,9v. Leistungstechnisch ein guter Kompromiss (rund 1900 MHz bei guten Chips) und weniger Spulenfiepen & Co. (wenn das stört) als mit 0,9x-1,0xv / 19XX - 20XX MHz.

-

Ein Undervolting - also weniger Spannung / Verbrauch - bringt auf jeden Fall bei jeder Karte was. Aber man muss es halt auch machen... Ansonsten kann man natürlich nochmal eine weitere Karte bestellen, und wenn es mit der nicht besser ist, eben wieder zurückschicken. Und ja, ein anderes / potenteres Netzteil könnte tatsächlich ebenfalls für Linderung sorgen. Das hat aber weniger was damit zu tun, für wieviel Watt es ausgelegt ist. Hochwertige, die zumeist nicht günstig sind, liefern hier i.d.R. die besten Ergebnisse.

-

macOS korrigiert mir bisschen viel ("Limited" statt "limiter"), muss das glaube ich mal ausstellen 🙄

-

edit: @einsteinchen war schneller Ja, das wird es sein. Das Geräusch entsteht durch die Vibration von elektrischen Komponenten auf deiner Grafikkarte. Bei manchen ist es etwas unangenehmer als bei anderen. Im Prinzip haben es aber alle. Was kannst du dagegen tun? Stromverbrauch / Spannung der Grafikkarte reduzieren (Undervolting). Viele Grafikkarten kannst du mit weniger Stromverbrauch / Spannung betreiben, ohne dass die Leistung verlierst. Lese dich in das Thema Undervolting ein. Am besten machst du das mit "MSI Afterburber". Aber auch Tools wie die von Asus funktionieren, ja. Was du außerdem dagegen tun kannst, ist ein fps limiter zu benutzen. Oftmals werden in Menüs nämlich deutlich mehr fps erreicht, das führt auch nochmal zu einem schrilleren Ton. Wenn du z.B. mit maximal 144 fps spielst, solltest du auch dort cappen (am besten bei 141 wenn du G-Sync nutzt). Cappen kannst du mit dem Riva Tool, was bei der Afterburner Installation mitinstalliert wird. Das bringt auch ein OSD mit. Bitte googeln, wenn du nicht weißt, was das bedeutet. Mit dem Limiter hast du dann also auch in Menüs usw. nicht mehr als 141 fps und somit weniger Spulenfiepen.

-

Ja, also ich suche und fixiere ja seit Jahren / mehreren GPU-Generation stets den bessere SweetSpot als der des Auslieferungszustandes. Mit einigermaßen guten Chips sind immer deutlich mehr Takt bei gleicher Spannung drinnen. Was ich aber lieber mache, ist eben Spannung wegzunehmen (also Undervolting), und ungefähr an die Taktraten von stock zu kommen. Meine 3090 betreibe ich mit 280-350W (also ordentlich weniger Abwärme) bei 1800 MHz @0,8v. Das entspricht einem OC von exakt 195 MHz. Speicher läuft auf +250 MHz, weil es mehr nicht mehr großartig bei der 3090 bringt. Übrigens wären 1800 MHz bei 0,8v für Turing gigantisch gewesen, bei Ampere klappt es viel öfter. Für die meisten sind wohl eher z.B. 1900 MHz @0,875-0,925v interessant. Das sind 5% mehr Takt als 1800 MHz, allerdings skaliert das in Games nicht, sprich das sind nur zwischen 1-3% mehr fps je nach Game. Ich nehme dann lieber die 1800 MHz bei 0,8v und spare mir Spulenfiepen und noch mehr Abwärme. Gerade in einem kleinen ITX Gehäuse macht das aber auch Sinn. Mit 1800 in allen Games bin ich leistungstechnisch noch sehr gut aufgestellt und das in einem kleinen Gehäuse, und dank den beiden Noctua A12 auf der 3090 auch noch extrem leise. Ich behaupte mein ITX-System ist leiser als viele andere ATX-Systeme (ohne merklich weniger Leistung in Games - nicht Benchmarks - zu haben).